Lobe Chat简介

Lobe Chat 是一款开源、可扩展的高性能聊天应用与开发框架,支持多种功能,包括语音合成和多模态插件系统,这使得它在交流体验上更加丰富多彩。

主要特色

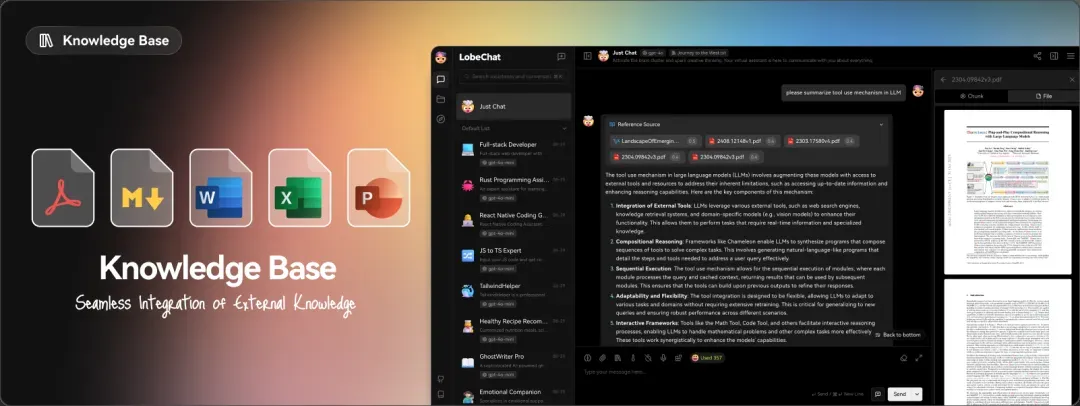

1. 文件上传与知识库功能

LobeChat 允许用户上传多类型文件,包括文档、图片、音频和视频等,同时可以创建和管理知识库。这一功能使得信息的管理与查找变得更加高效,提升了对话的互动性与成果。

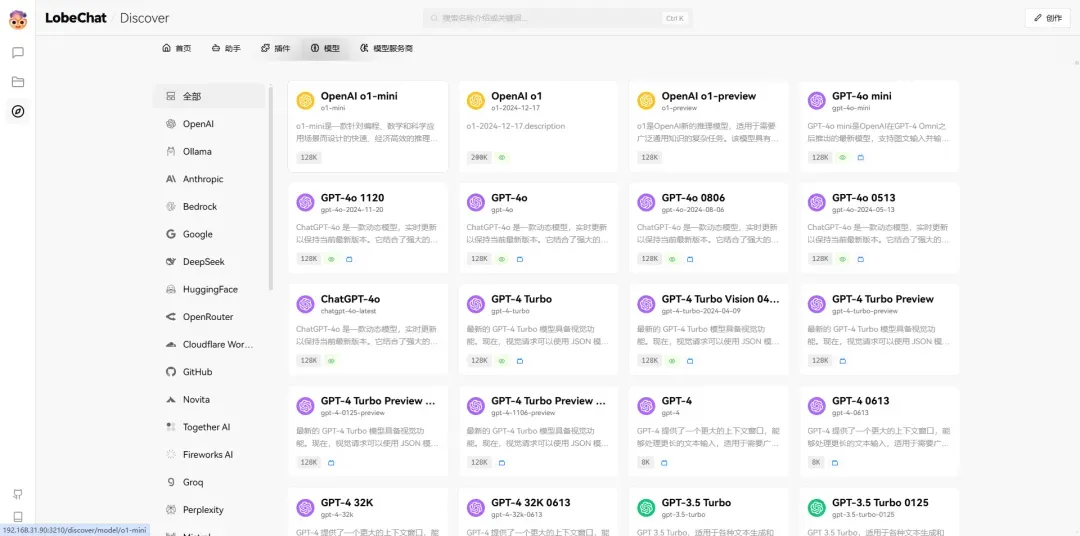

2. 多模型服务提供者的支持

为了满足多元化的社区需求,LobeChat 不再依赖单一的模型服务提供者。在发展的过程中,我们引入了多种模型服务商,从而为用户提供更多的选择和更丰富的会话体验。

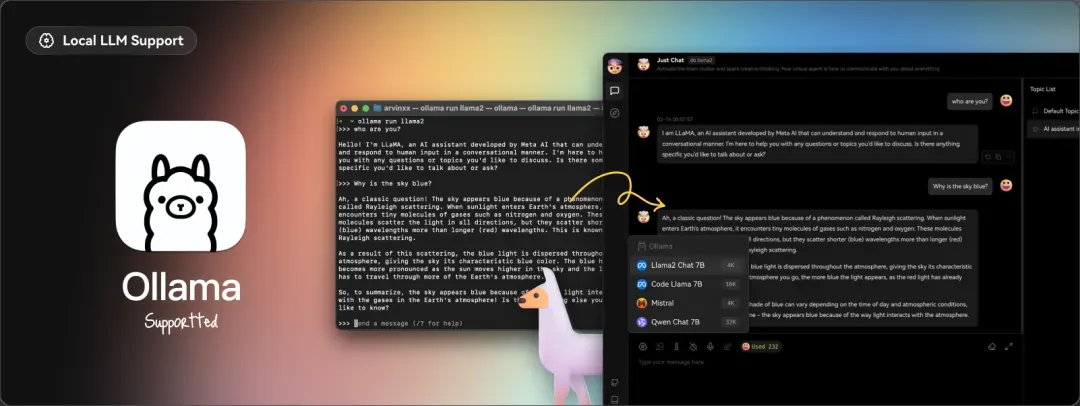

3. 本地大语言模型 (LLM) 的支持

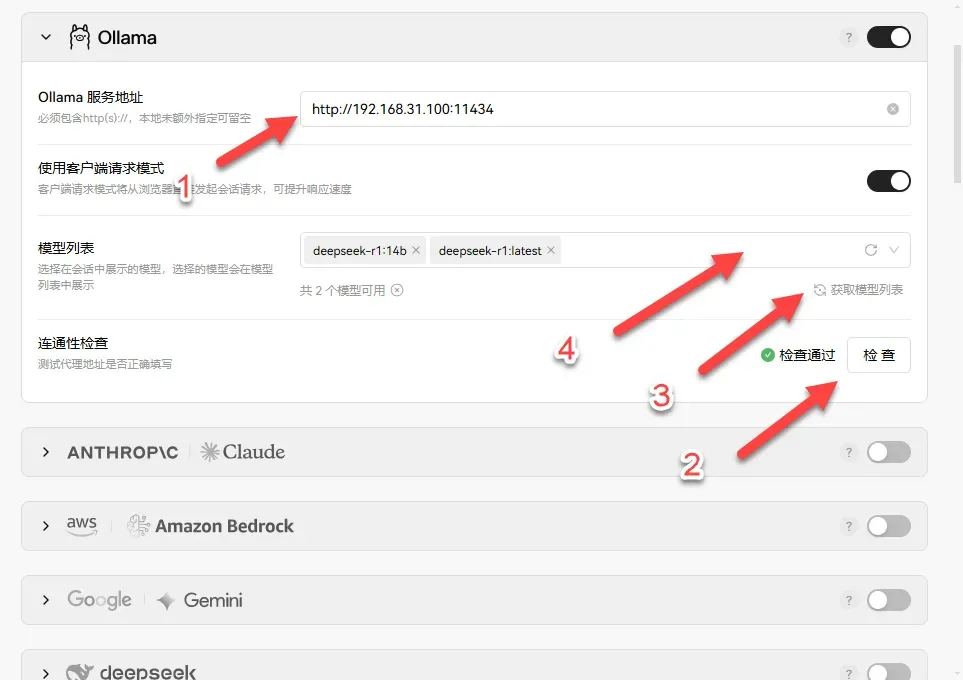

LobeChat 与 Ollama 进行集成,使得用户能够灵活使用本地或第三方模型,满足特定应用的需求。

4. 视觉识别模型

通过集成 OpenAI 最新的 gpt-4-vision模型,LobeChat 能够识别用户上传的图像,并据此提供智能对话,极大地丰富了聊天场景的多样性。

5. TTS与STT语音交互

我们的应用强大地支持文字转语音和语音转文字技术,使用户不仅能通过文字与助手交流,还能享受如同与真实人类沟通的感觉。

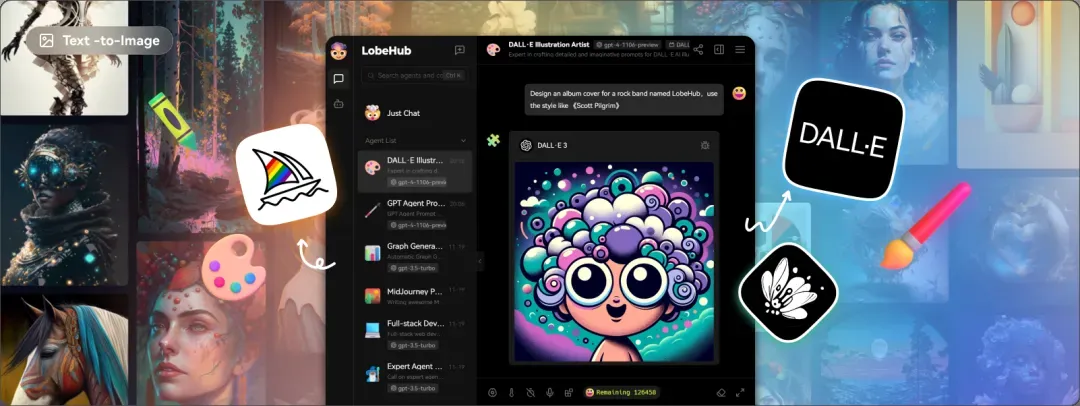

6. 文生图功能

LobeChat 现在支持最新的文本到图片生成技术,用户在与助手对话时可以直接调用这些工具进行创作。依托 DALL-E 3、MidJourney 和 Pollinations 等AI工具,用户可以更私密地实现创意表达。

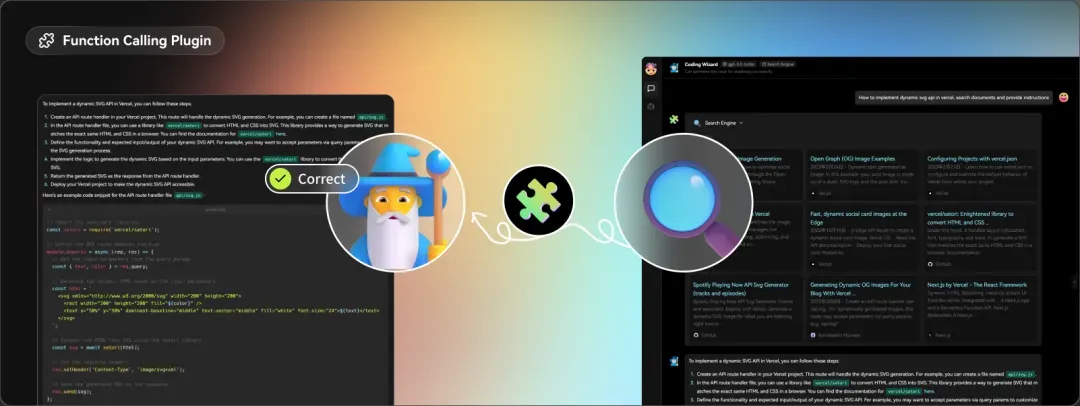

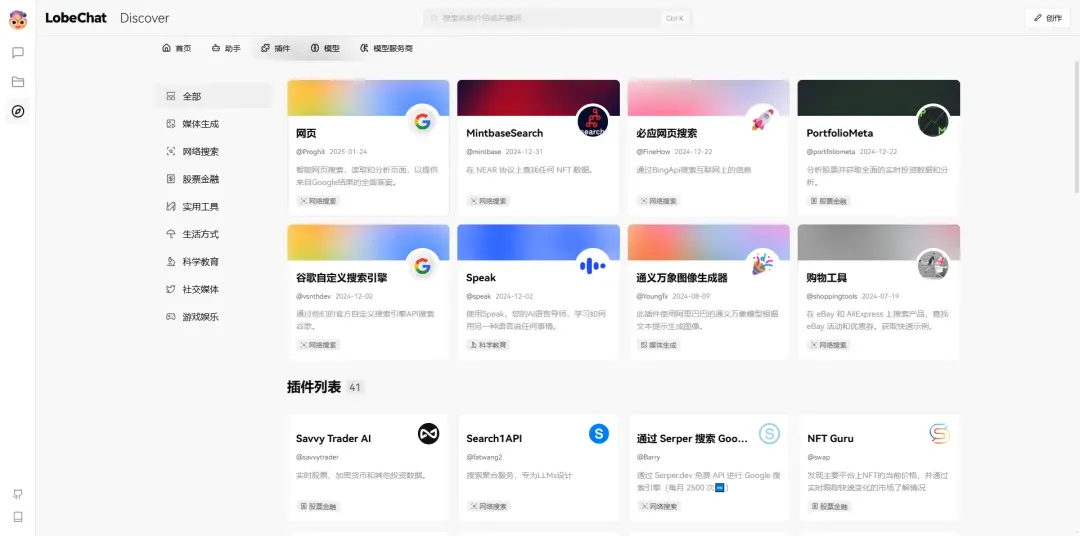

7. 插件系统 (Tools Calling)

LobeChat 具备一个功能强大的插件生态系统,极大提升了其灵活性与实用性,为用户的体验增添了更多可能性。

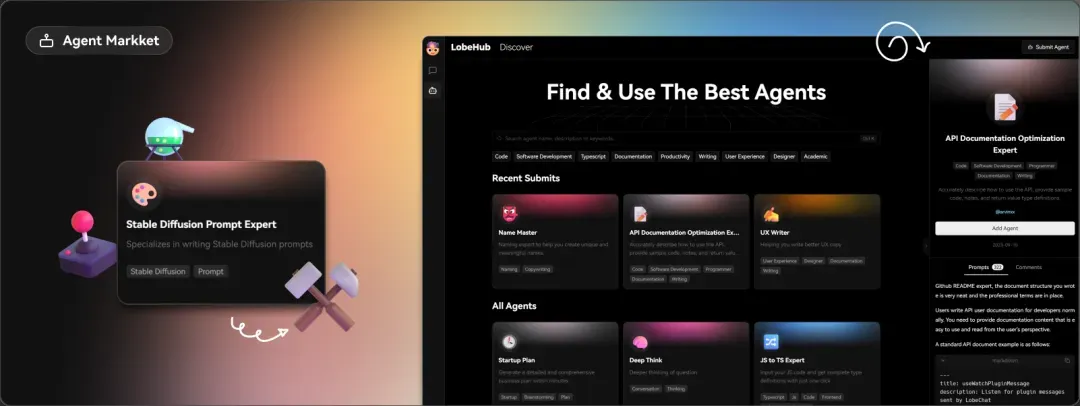

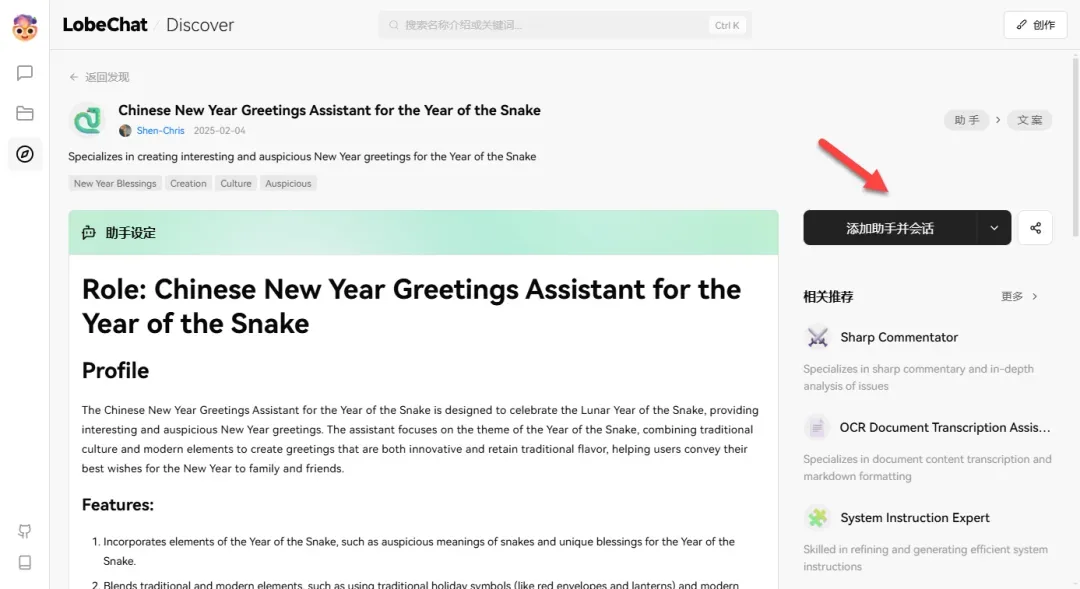

8. 助手市场 (GPTs)

在我们的助手市场中,用户可以找到丰富多样的创意助手,充分展现个人智慧,并在工作和学习中提供便捷。

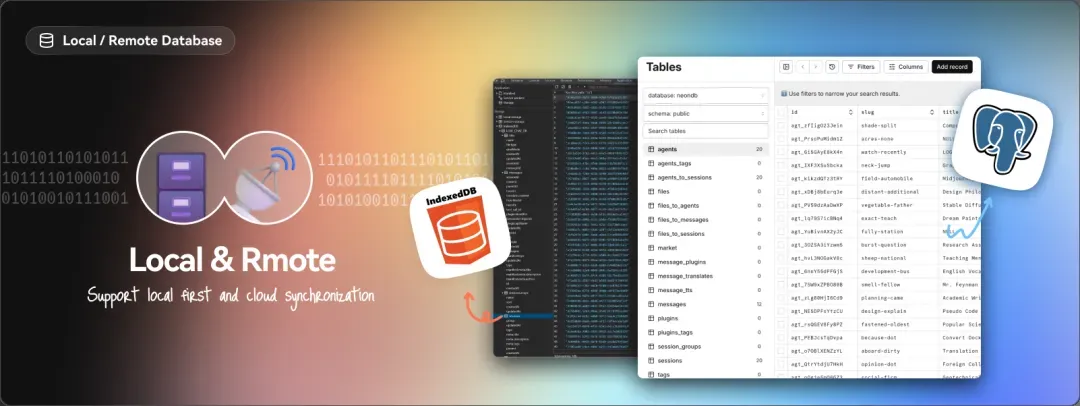

9. 多种数据库配置支持

LobeChat 允许使用本地数据库和远程服务端数据库。用户可以根据自身需求来选择部署方式,如偏好隐私,可选择本地数据库;需要便捷体验时,可选择服务端 PostgreSQL 数据库。

10. 多用户管理功能

LobeChat 提供了两种主要的用户管理方案:next-auth 和 Clerk,分别适应于普通用户和需要更高级管理功能的用户,确保数据安全与隐私。

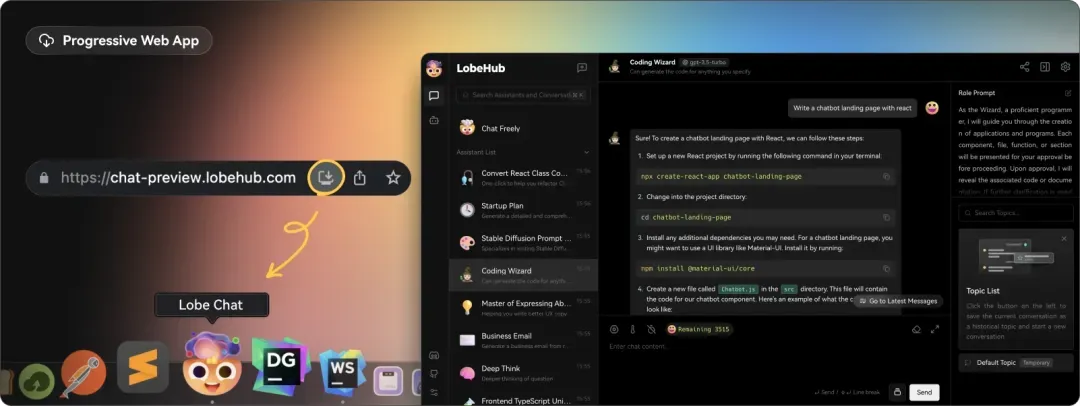

11. 渐进式Web应用 (PWA)

LobeChat 采用 PWA 技术,致力于为用户提供接近原生应用的体验,确保在各类设备上的优质表现。

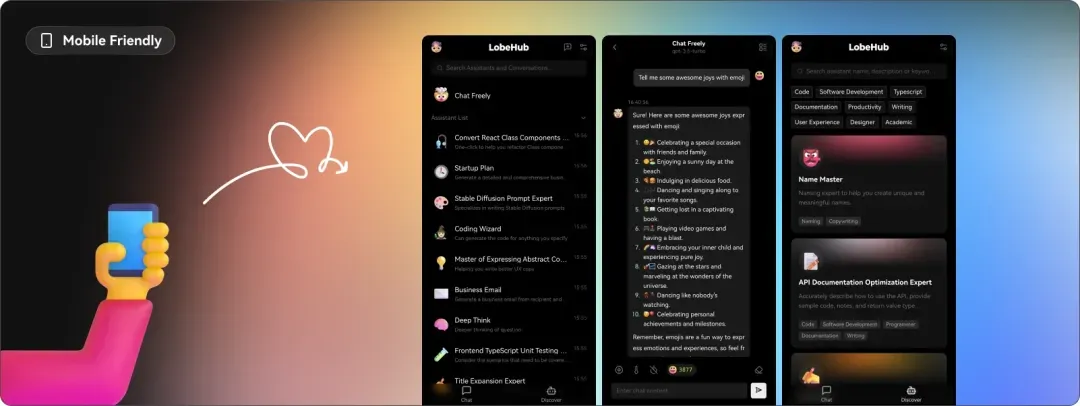

12. 移动端优化设计

我们针对移动设备进行了全面优化,以提升用户体验,确保在手机上流畅操作。

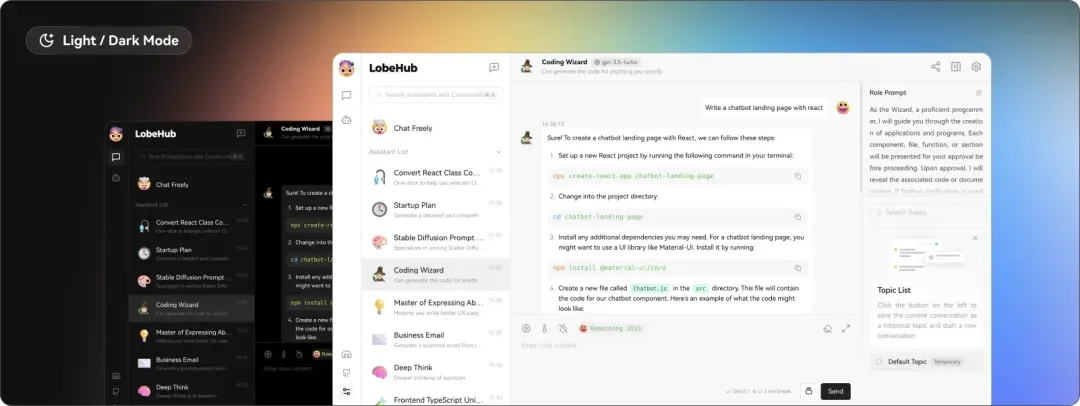

13. 自定义主题功能

LobeChat 提供灵活的主题选择,用户可以根据个人喜好调整色彩和主题模式,以实现更个性化的使用体验。

安装指南

使用 Docker Compose 进行部署:

services:

lobe-chat:

image: lobehub/lobe-chat:latest

container_name: lobe-chat

environment:

- ACCESS_CODE=lobe66

- OPENAI_API_KEY=sk-xxxx

- OPENAI_PROXY_URL=https://api-proxy.com/v1

ports:

- "3210:3210"

参数说明

- ACCESS_CODE:访问网页所用密码(可选)

- OPENAI_API_KEY:ChatGPT API 密钥(可选)

- OPENAI_PROXY_URL:第三方平台的接口代理(可选)

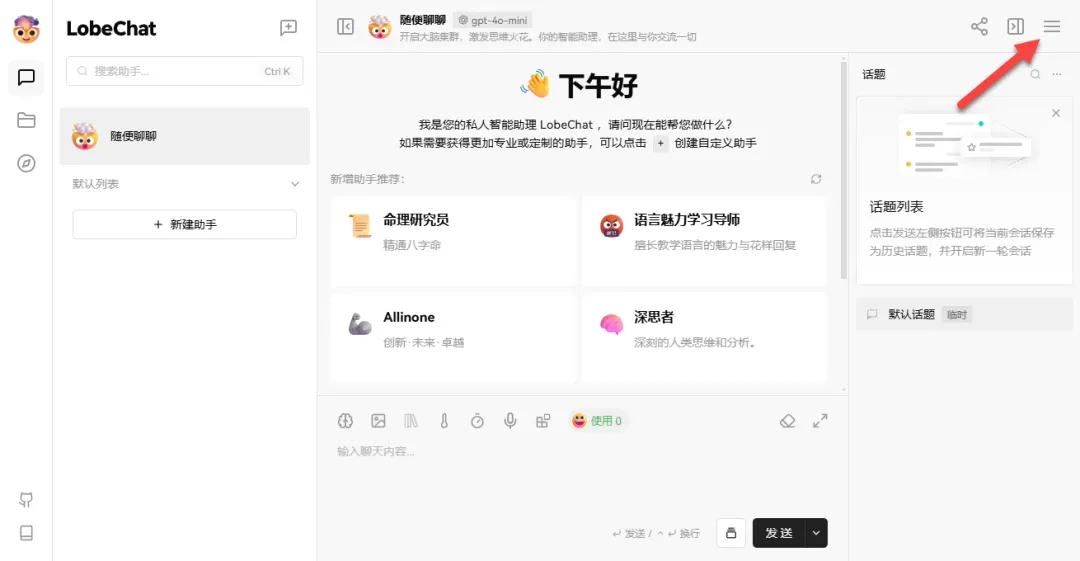

使用方法

在浏览器中输入 http://NAS的IP:3210 即可访问界面。

在左上角点击“会话设置”,可以切换主题。

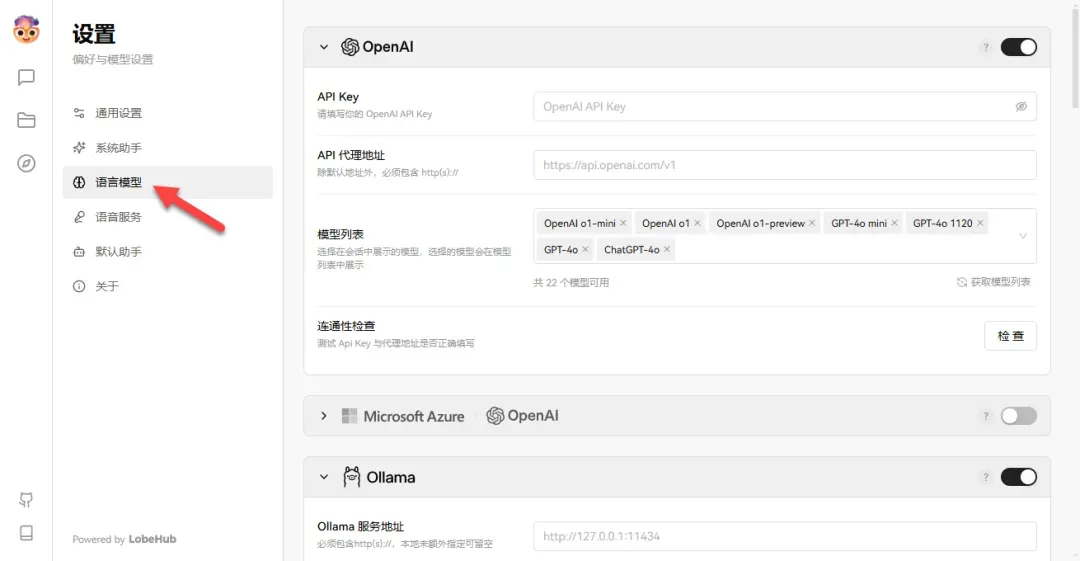

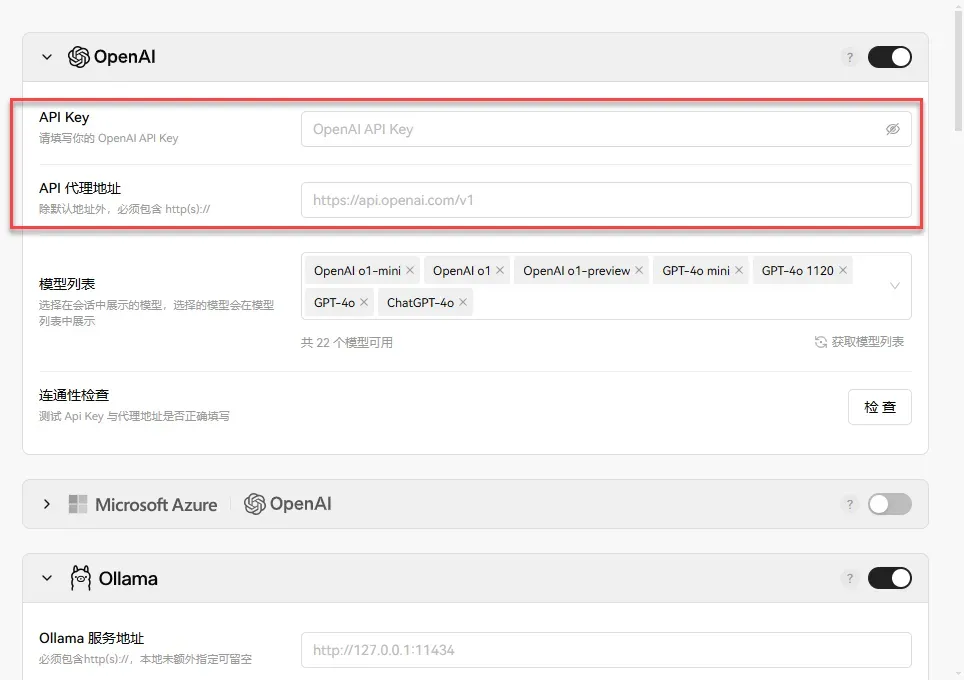

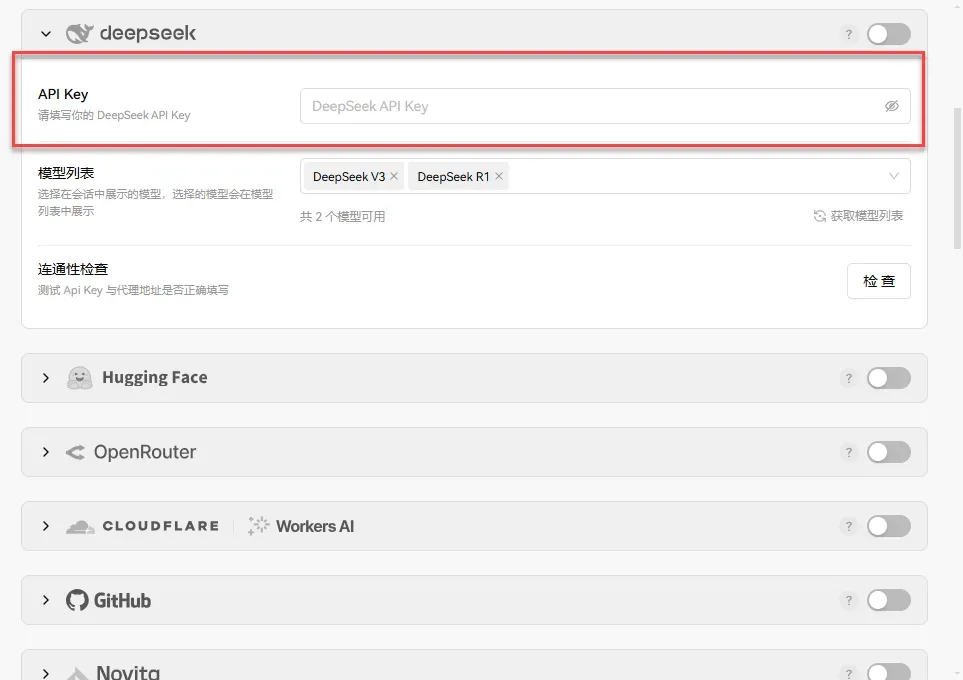

设置所需调用的语言模型。

如果使用 OpenAI,可以通过容器参数更方便地添加。

最近流行的 deepseek 也受支持。

提示:

若无法连接,可能是跨越问题,请设置 Ollama 添加新变量“OLLAMA_ORIGINS=*”。

手把手教你在 NAS 上部署本地 DeepSeek-R1 大语言模型

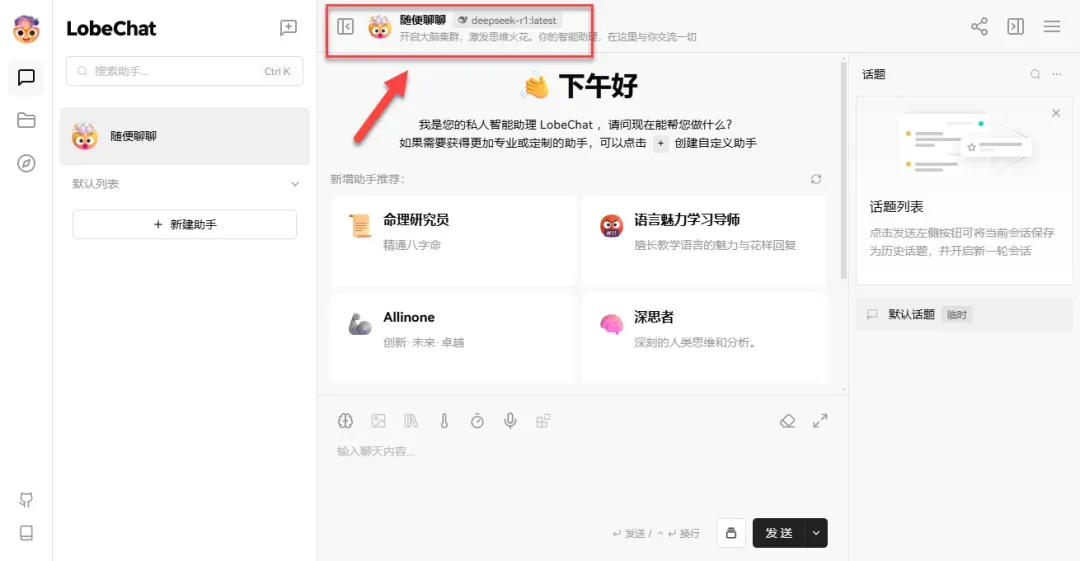

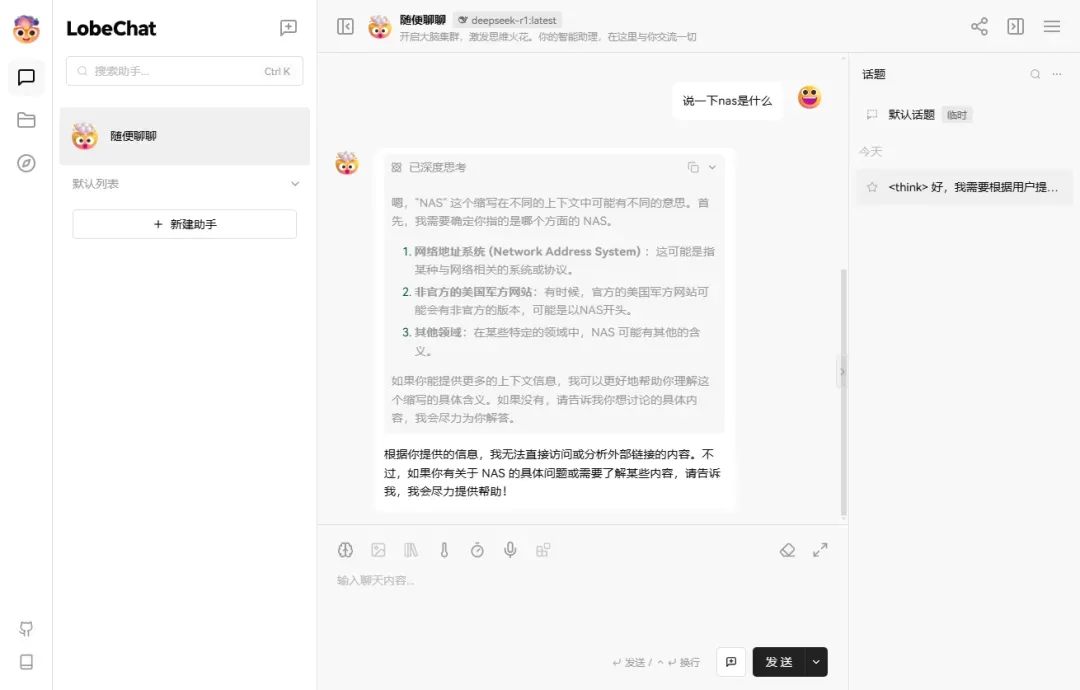

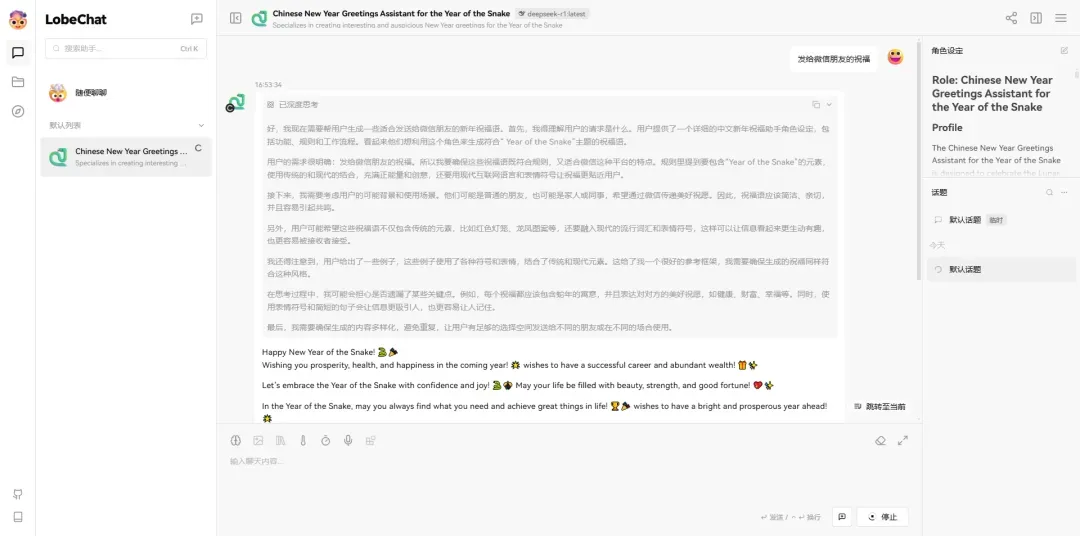

当前我调用的是前期本地部署的 Ollama 框架。

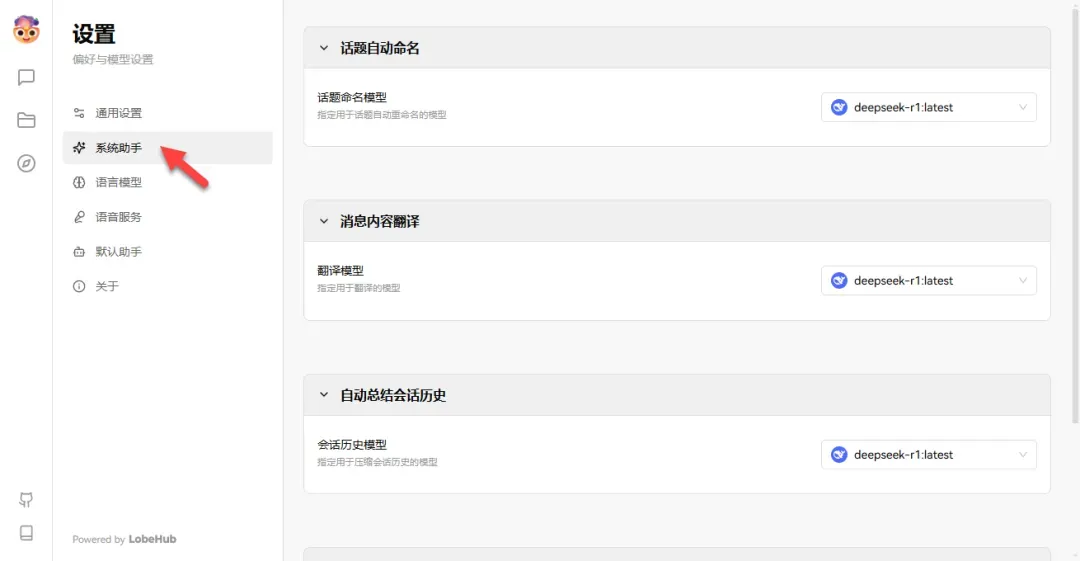

在系统助手中可以设置默认调用的模型。

在回到会话界面后,默认调用的模型可以正常工作。

能够顺利进行对话,且深度思考同样可以正常显示。

由于未部署数据库,因此文件上传功能暂时不可用,用户可自行设置。

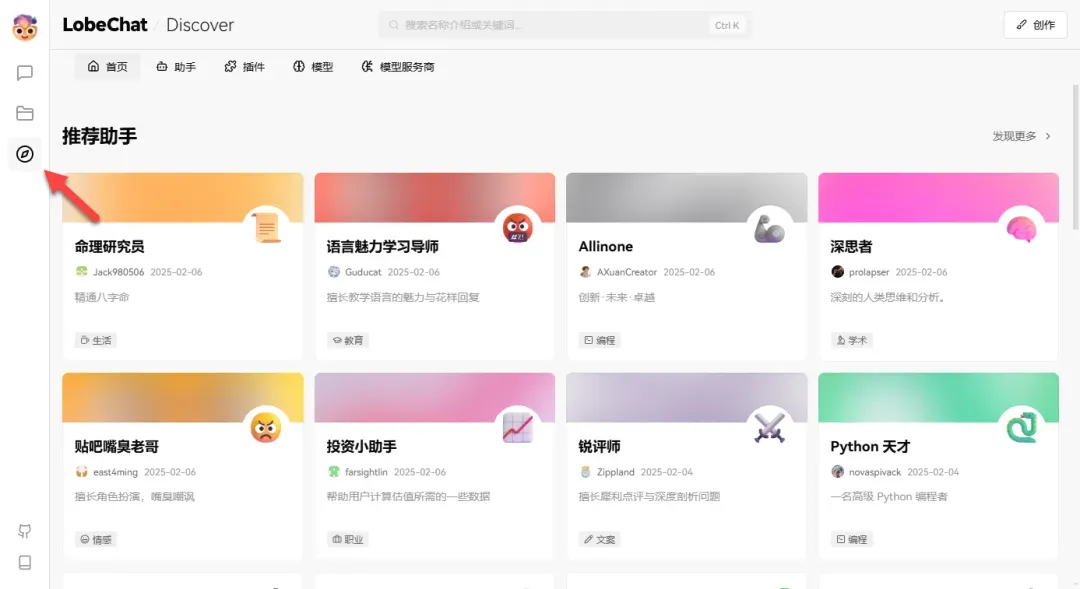

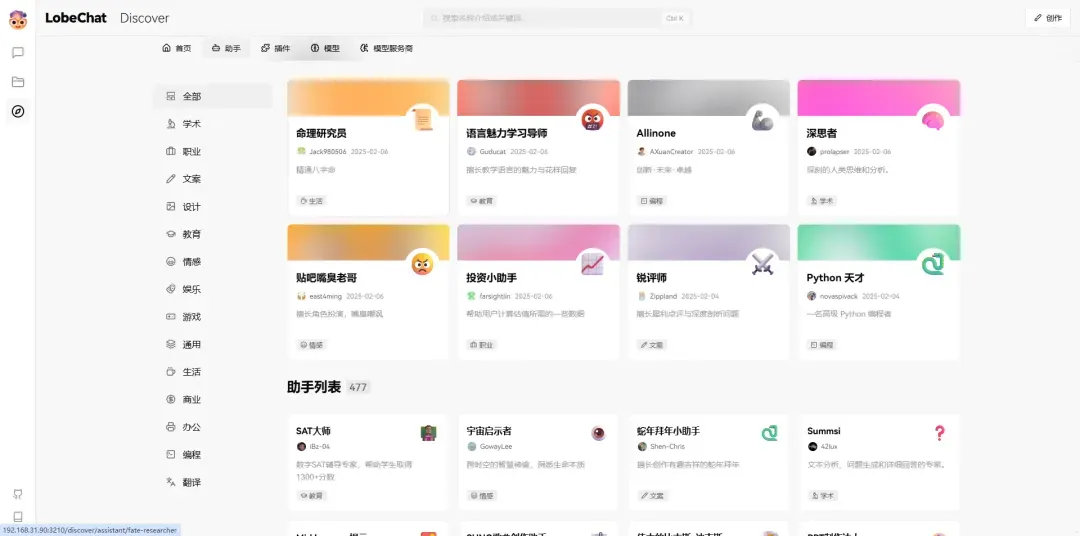

在这里,用户能够使用助手、插件及各种模型等多样功能。

助手相当于一个角色扮演功能。

插件则实现额外的功能扩展。

模型介绍则是提供每个模型相关信息。

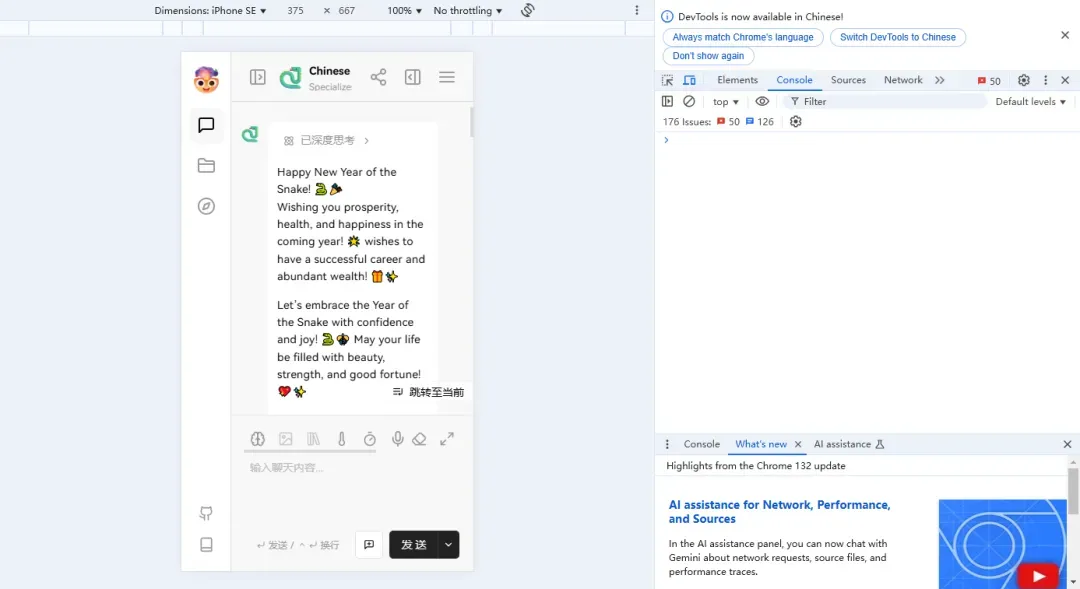

这里我添加了一个拜年助手进行测试。

效果相当不错,不过在使用本地模型时,回复速度稍慢。

网页在移动端也特别进行了适配。

总结

无论是进行 AI 聊天会话,还是调用 API 接口,这款应用都值得部署。使用起来简单易上手,操作界面设计美观,设置分门别类,并通知丰富的插件生态系统和助手市场。