Open WebUI简介

Open WebUI是一个具有扩展性、功能丰富且用户友好的自托管 AI 平台,旨在实现完全离线的操作。此平台支持多种 LLM(大语言模型)运行器,例如 Ollama 以及与 OpenAI API 兼容的接口,还内置了 RAG(检索增强生成)推理引擎,使其成为一款极具潜力的 AI 部署解决方案。

安装指南

Docker Compose配置

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

volumes:

- /vol1/1000/docker/open-webui:/app/backend/data

ports:

- "8080:8080"

提示:由于文件体积较大,请确保您的网络连接稳定,以便顺利拉取。

使用步骤

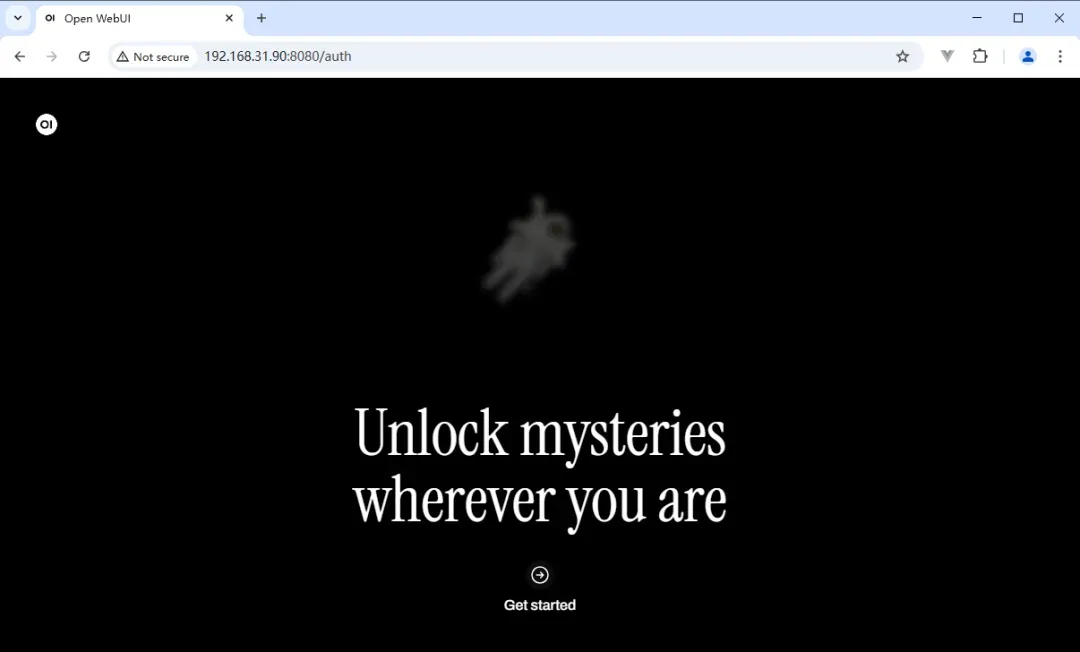

在浏览器中输入 http://NAS的IP:8080,即可看到界面。

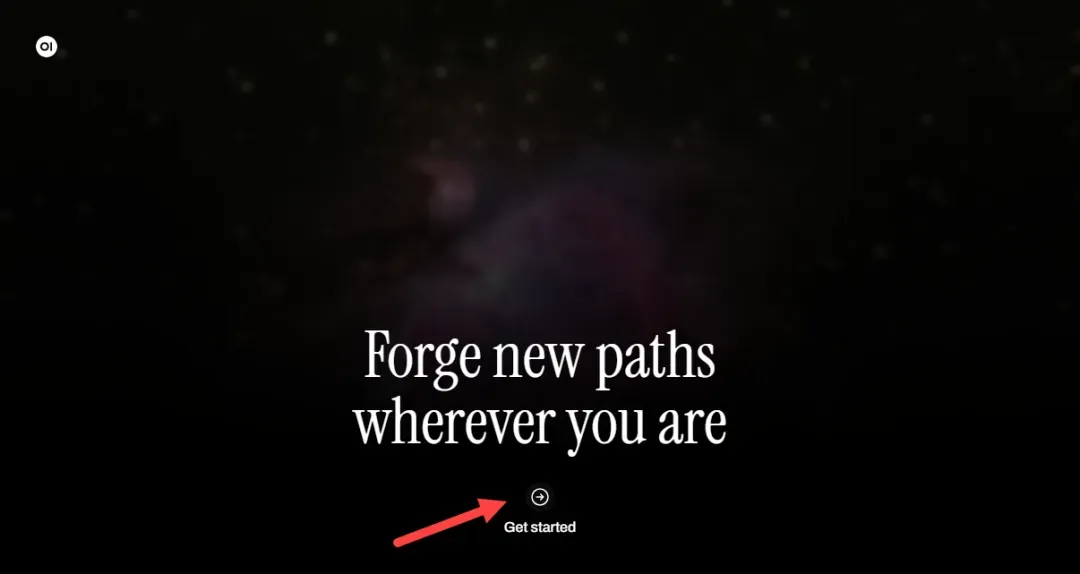

接下来,点击“开始”。

在首次使用时,您需要先创建账号。请按照要求填写相关信息。

点击“确认,开始使用”。

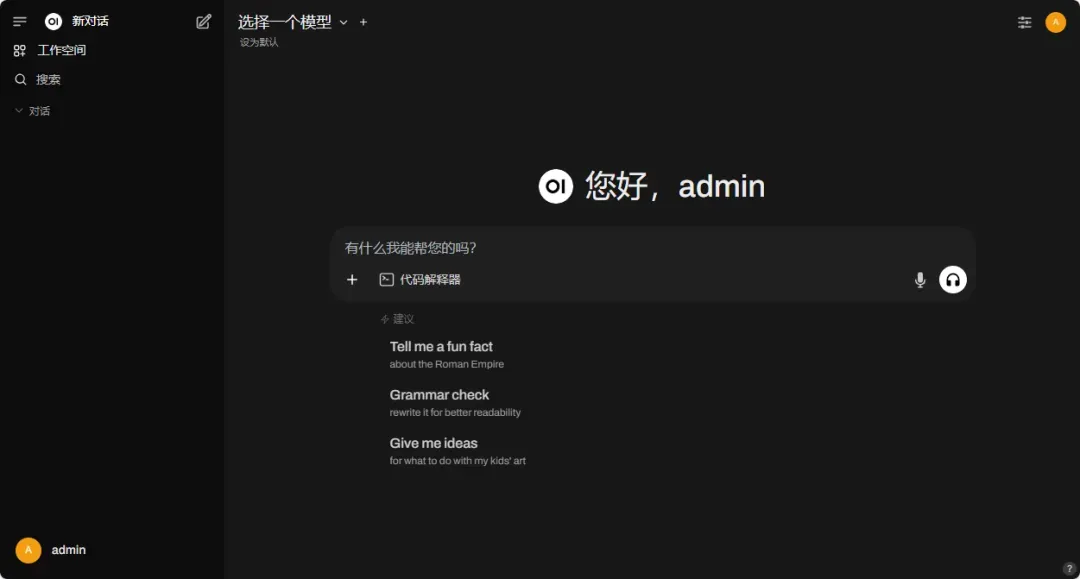

这时您将进入对话面板。

在左下角,点击设置图标。

您可以选择多种颜色主题。

选择深色主题,可以为界面带来更加高级的视觉效果。

点击“管理员面板”来进行更深入的管理。

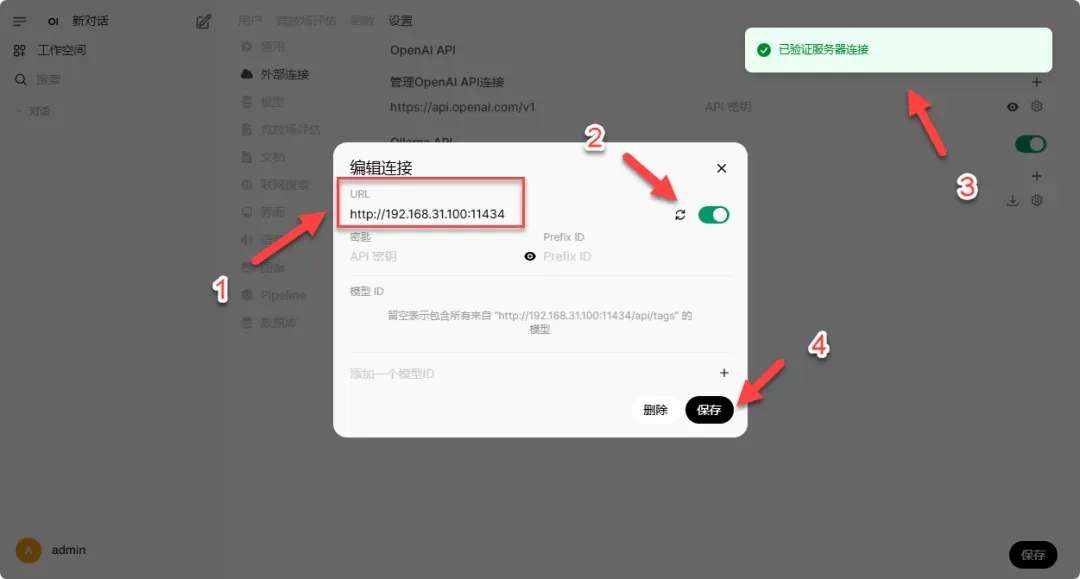

您可以在此管理 Ollama API 的连接性。

提示:若连接不成功,可能需要进行跨域设置,为 Ollama 添加一个新的环境变量“OLLAMA_ORIGINS=*”。

您可以通过以下链接获取更多信息:https://mp.weixin.qq.com/s/ctsPIBmUnQzyrRxgn-VJVw?token=747806263&lang=zh_CN

在这里,您可以连接先前部署的 Ollama。

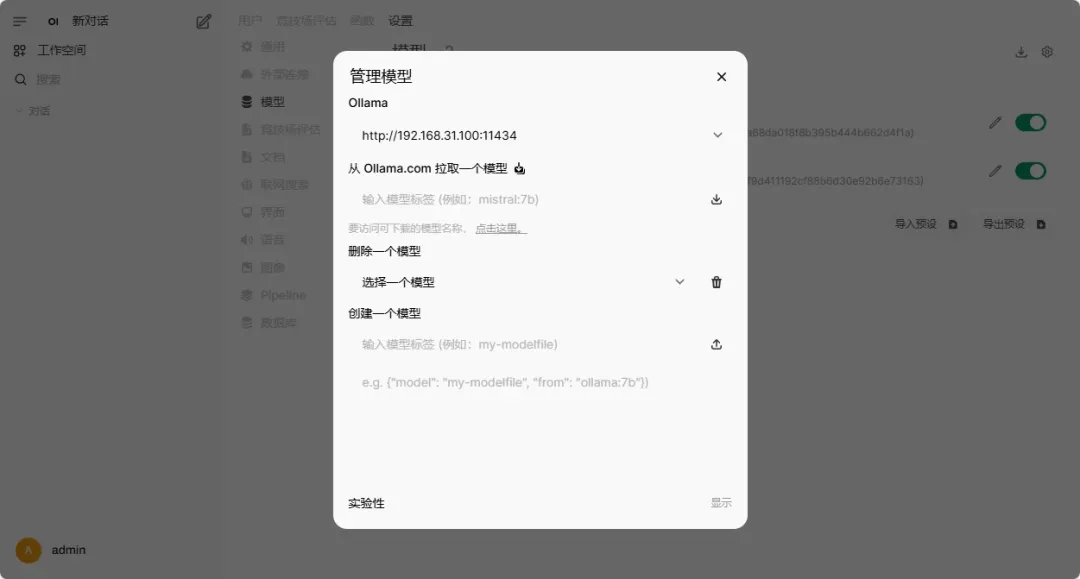

在此处可以查看到已经下载的模型。

通过点击“管理模型”进入相关设置。

您不需要使用命令行,就可以通过图形界面管理模型。

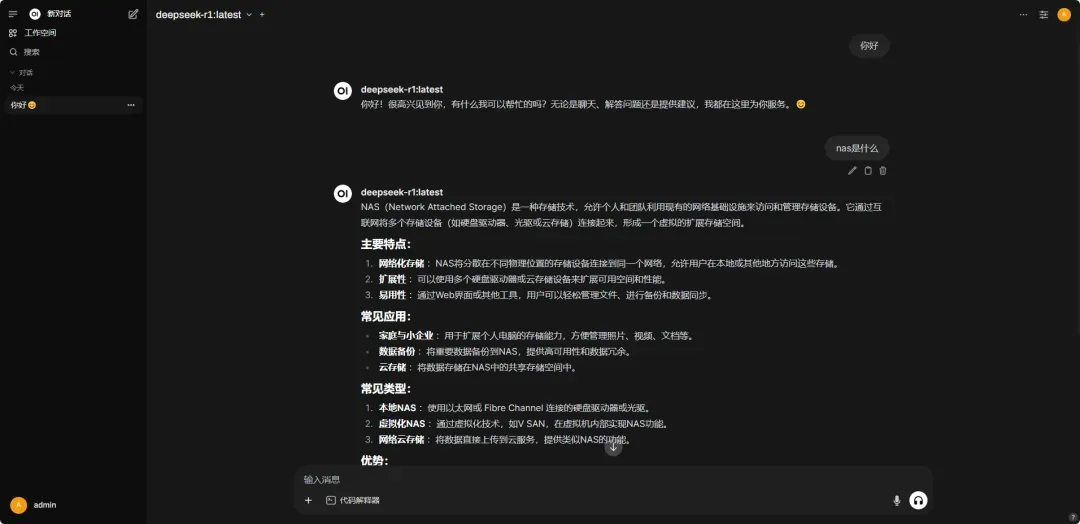

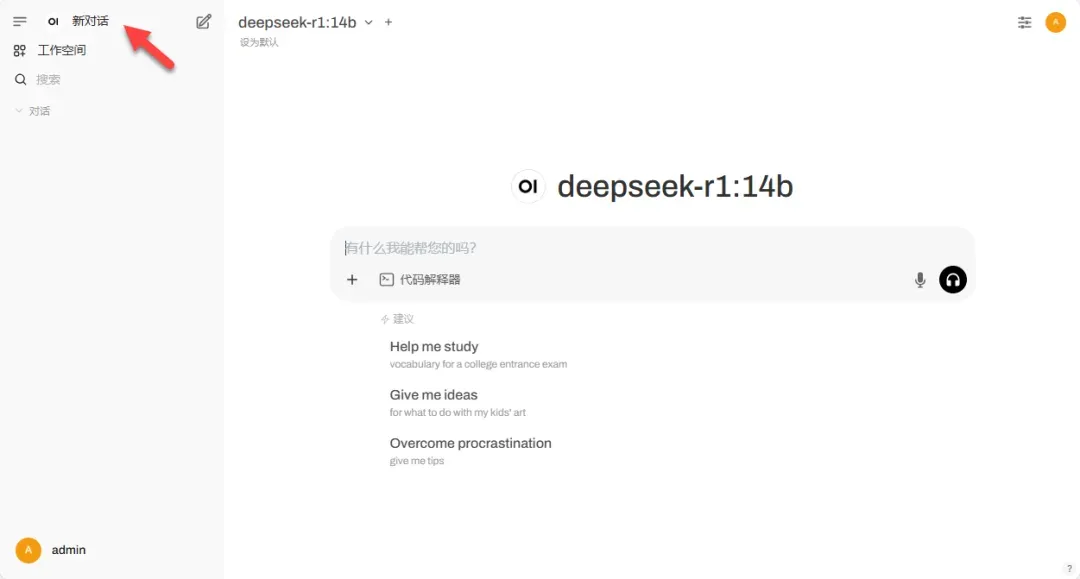

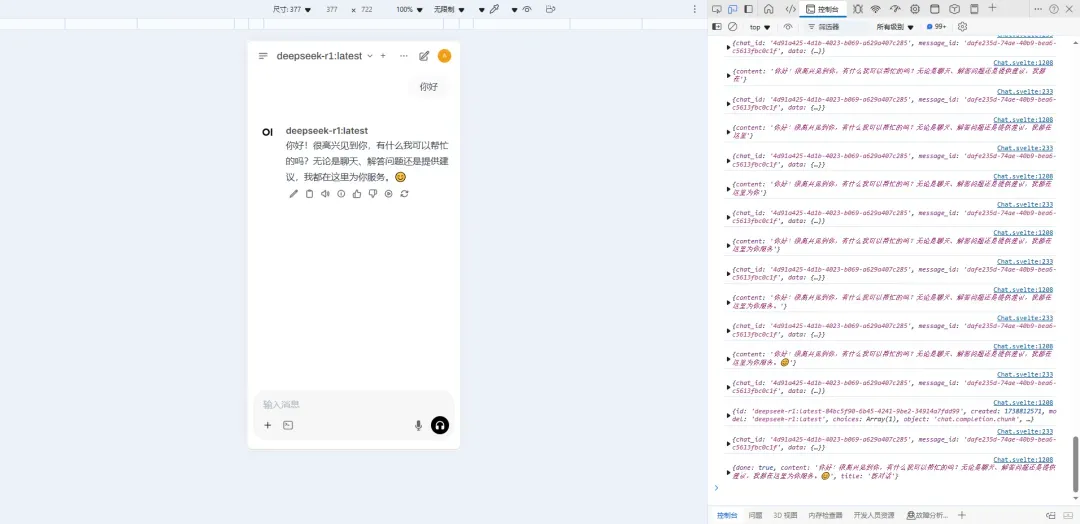

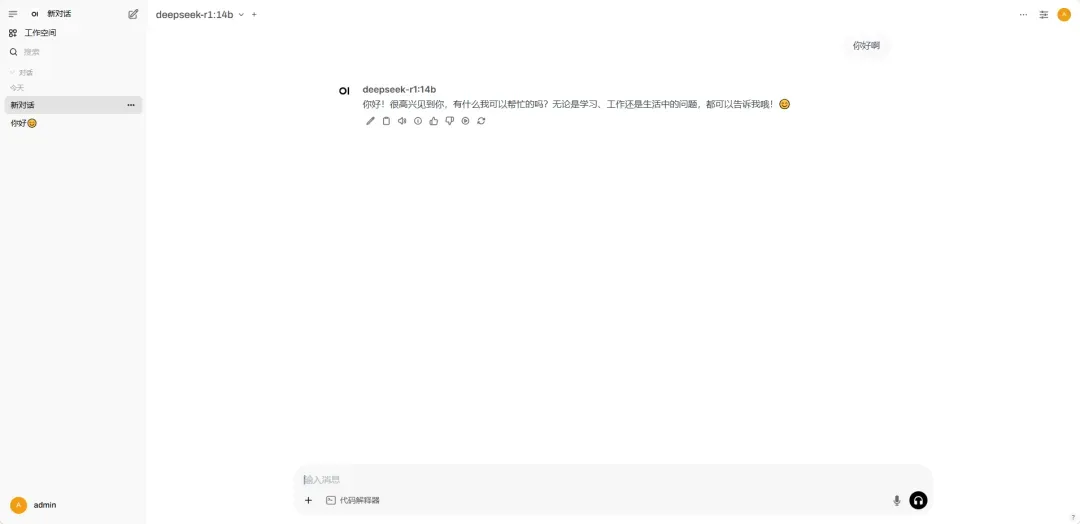

返回面板,您可以点击“创建新对话”。

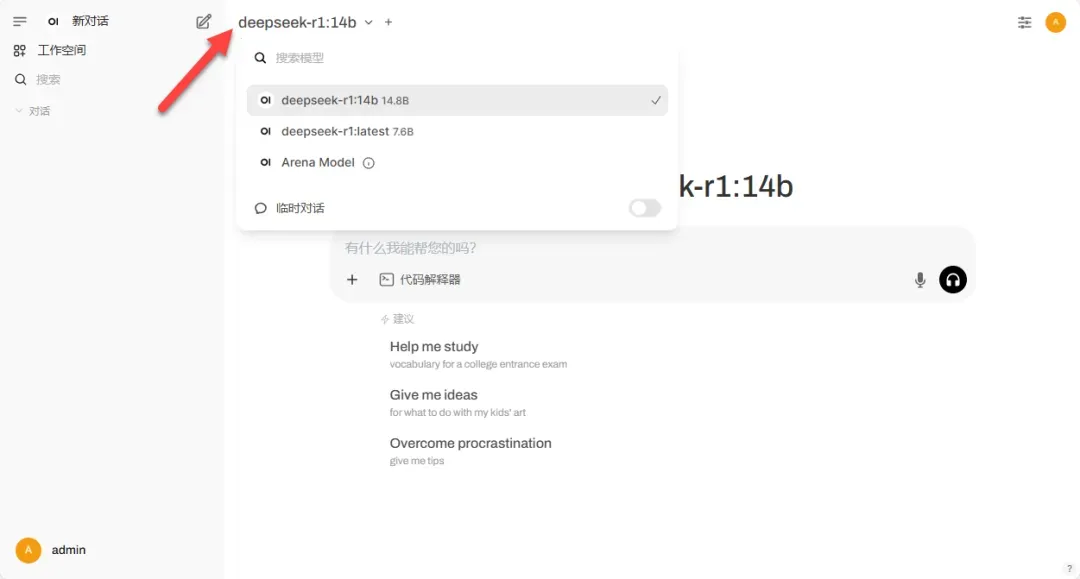

界面上可切换不同模型进行对话。

模型将正常进行回复,但有时速度可能会比直接命令行输入慢一些。

该平台也针对移动端做了适配,用户在手机上同样可以流畅使用。

总结与体验

如果您已经在 Ollama 中部署了相关框架,强烈推荐您一起使用这个平台。其图形化界面优化了操作体验,同时对新手用户来说上手也更加简单,此外,它为进阶用户提供了大量可调节的功能。

综合推荐:⭐⭐⭐(视需求而定)

使用体验:⭐⭐(一般)

部署难易:⭐⭐(简单)

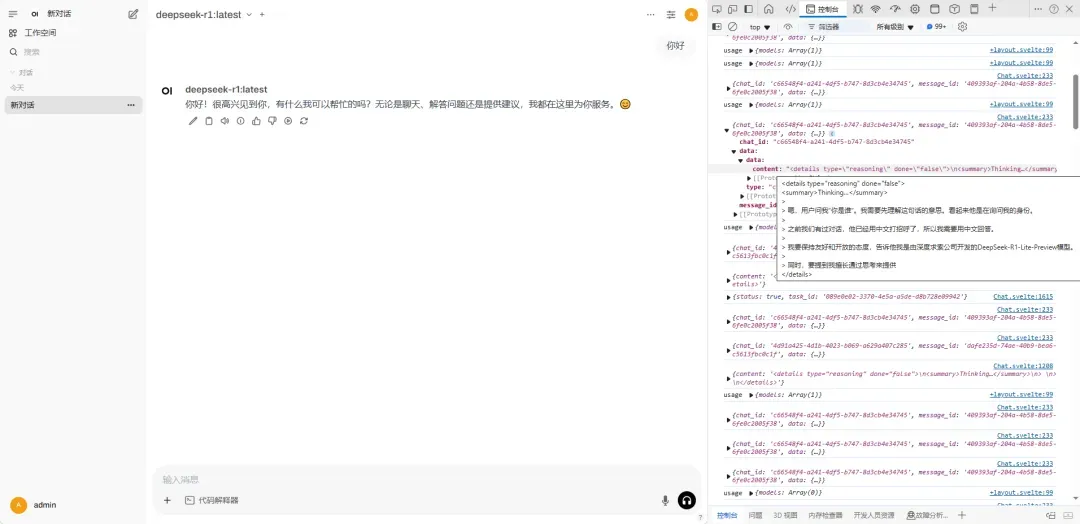

需要注意的是,兼容性仍有一些问题,例如“deepseek-r1”模型的思考过程并未显示。

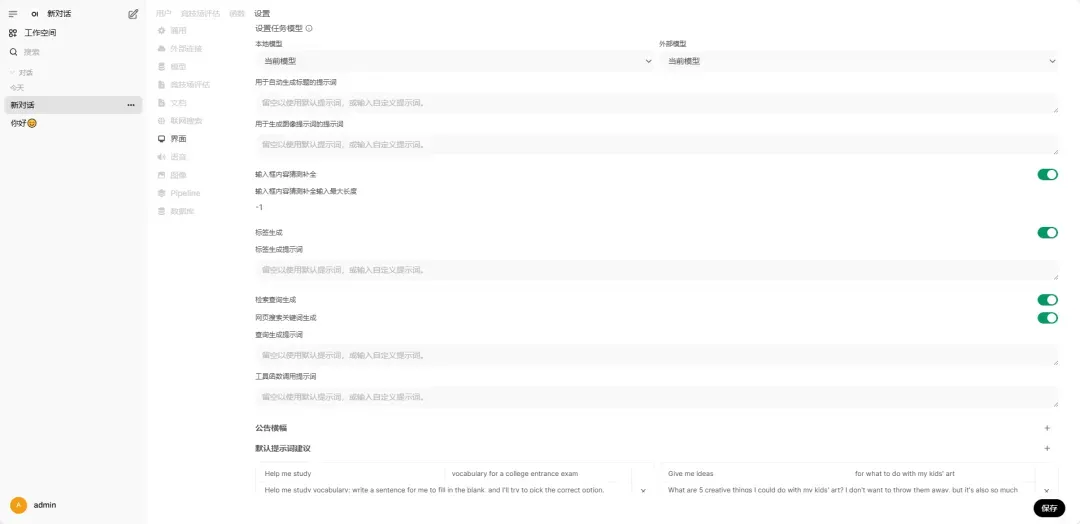

设置选项较多,具体内容不一一展开介绍。

占用资源情况方面,尽管该平台仅为前端界面,依旧对内存有一定的需求。