欢迎阅读本期文章!

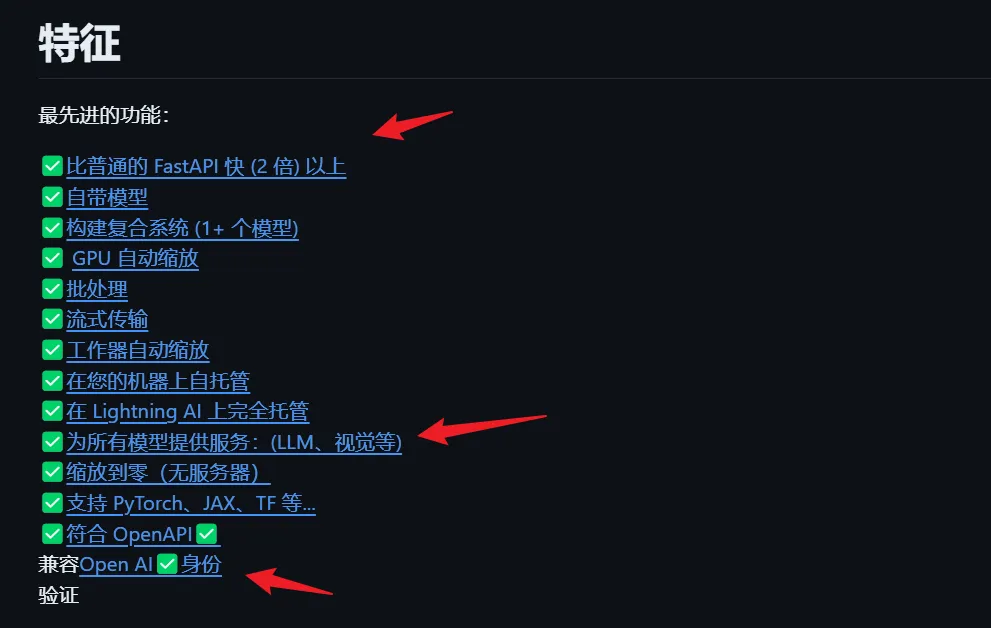

LitServe是一款灵活且易于使用的服务引擎,专为基于FastAPI构建的AI模型而设计。其具备批处理、流式处理和GPU自动扩缩等功能,无需为每个模型重复搭建FastAPI服务器。

LitServe的优势特性

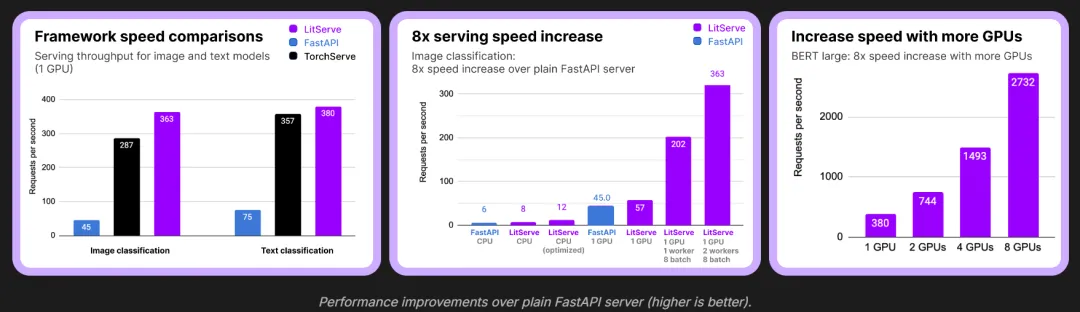

LitServe针对AI工作负载进行了优化,其多任务处理功能使得性能比FastAPI至少提升2倍。借助批处理和GPU自动缩放等附加功能,LitServe能够高效扩展,处理比FastAPI和TorchServe更多的并发请求,将性能提升至2倍以上。

您可以在此处查看完整基准测试(数字越高越好)。

LitServe的性能优势已经通过图像和文本分类ML任务得到验证,这种优势同样扩展到其他机器学习任务,如嵌入、LLM服务、音频处理、分割、对象检测和摘要。

💡 LLM服务注意事项:对于高性能LLM服务(例如Ollama/VLLM),建议将LitServe与LitGPT结合使用,或构建自定义的VLLM类服务器。为了最大限度提升LLM性能,建议使用KV缓存等优化,LitServe能轻松实现这些功能。

优秀的功能与简单的使用体验

LitServe提供了一种便捷的服务部署方式,可以根据不同的AI模型定义专属服务器。

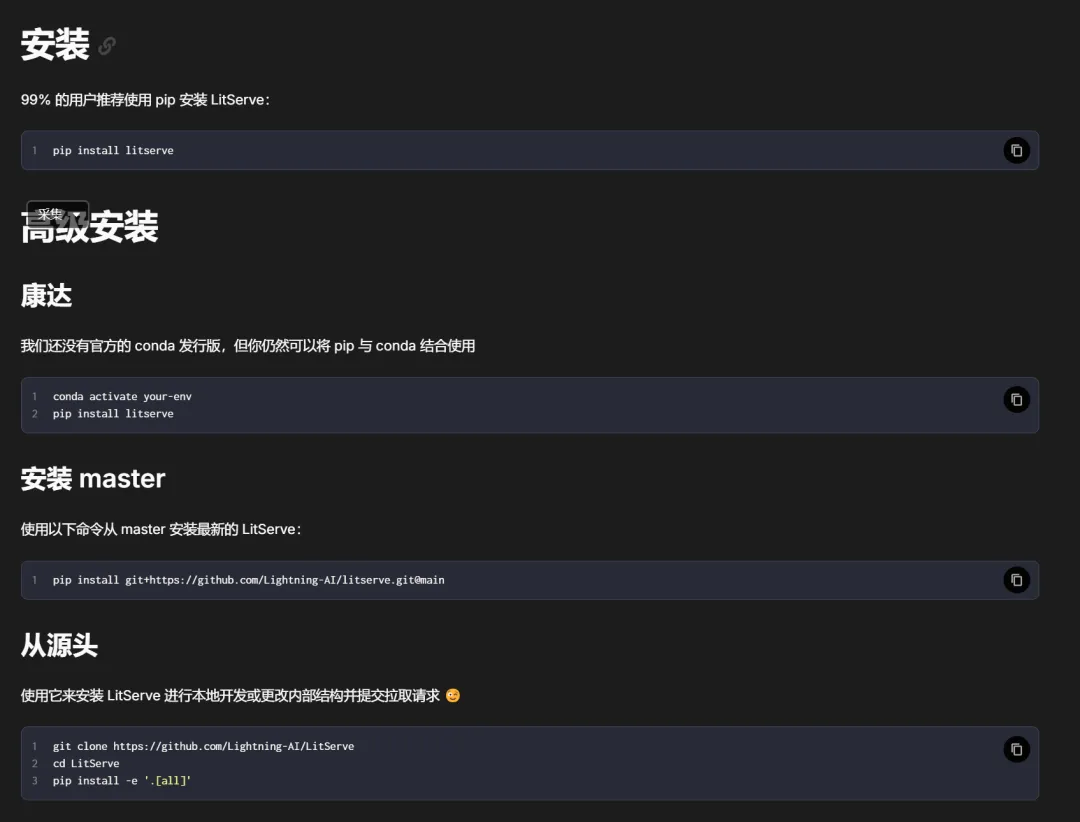

安装litserve包非常简单:

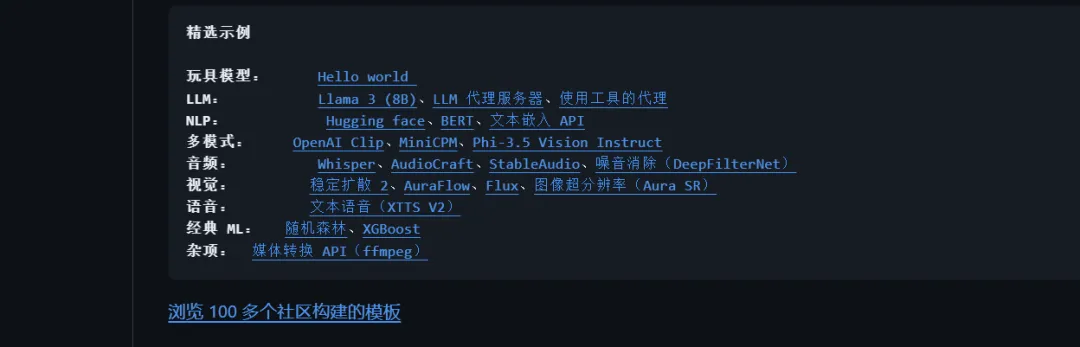

从大型模型到语音、视频和图像的各种部署示例应有尽有:

对比个人部署与LitServe提供的云部署方案:

官网资源

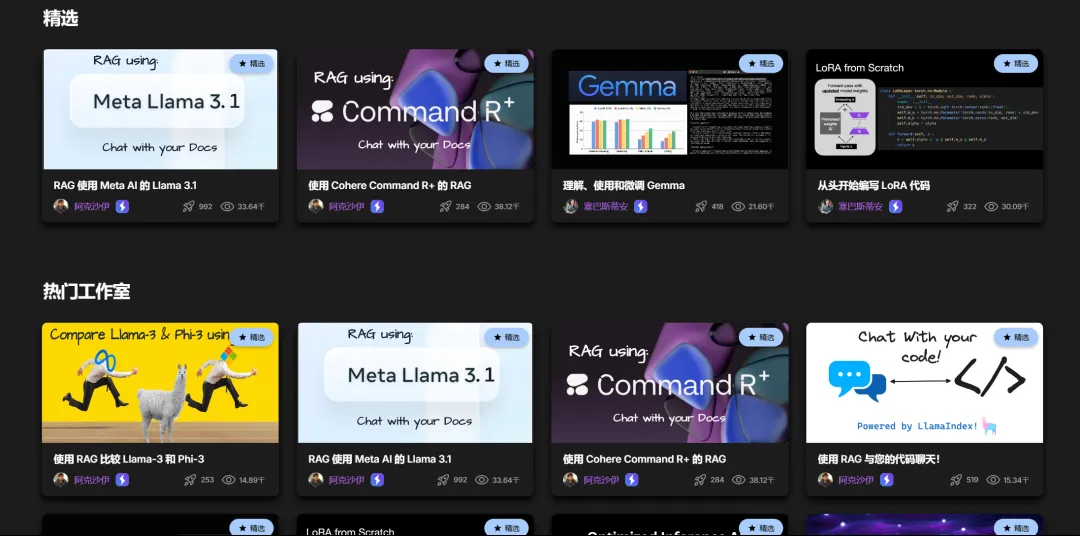

在Lightning官网上,您可以找到众多热门资源和博客,包括:使用LitServe部署Phi3.5 Vision API、使用Flux部署图像生成API。

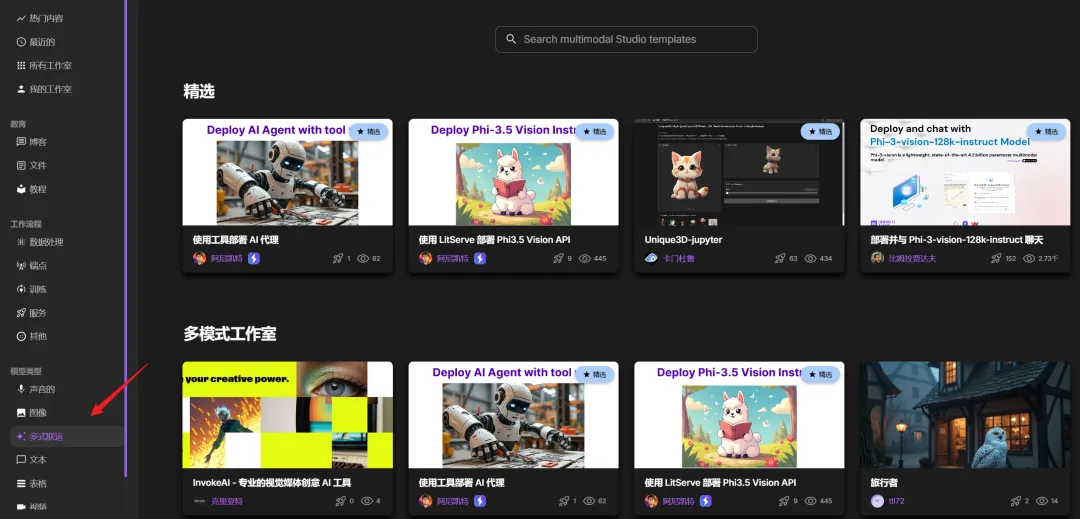

LitServe支持多种模态的模型部署,从声音、图像到视频均可实现。

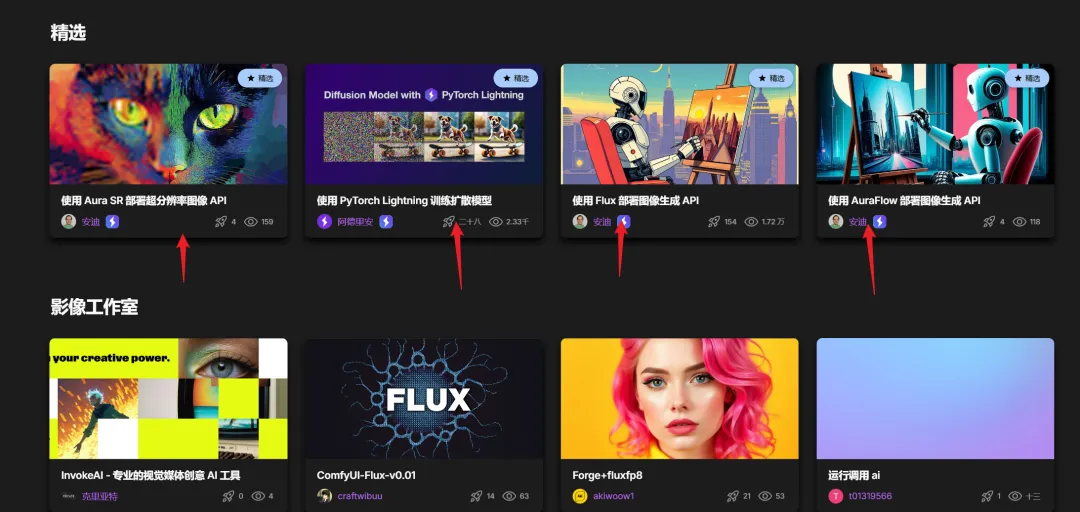

如图所示,您可以使用Flux、超分辨率、comfyui等进行图像处理:

通过LitServe,您可以实现多模态的部署,例如Phi3.5 Vision和Phi-3-vision-128k-instruct。

精彩博客推荐

从数据处理到部署服务,官网提供了一系列详细流程和最佳实践,每一篇博客都可以助您一臂之力。