AingDesk 是一款功能强大且易于使用的 AI 助手工具,它支持知识库管理、多种模型 API 集成、内容分享、联网搜索以及智能体创建等功能,目前正处于快速发展和完善阶段。

核心功能

AingDesk 提供了多项实用功能,包括:

- 一键部署本地 AI 模型及主流模型 API

- 建立和管理本地知识库

- 创建和配置智能体

- 支持在线分享功能,方便与他人协作

- 集成联网搜索能力

- 适用于服务器端部署

- 即将支持单次多模型同时对话

安装指南

使用 Docker Compose 部署

通过以下 Docker Compose 配置可以快速部署 AingDesk 服务:

services:

aingdesk:

image: aingdesk/aingdesk:latest

container_name: aingdesk

ports:

- 7071:7071

volumes:

- /vol1/1000/docker/aingdesk/data:/aingdesk/data

- /vol1/1000/docker/aingdesk/uploads:/aingdesk/uploads

- /vol1/1000/docker/aingdesk/logs:/aingdesk/logs

restart: always

参数说明

/aingdesk/data:用于存储服务的核心数据/aingdesk/uploads:存储用户上传的文件/aingdesk/logs:收集服务运行过程中的日志信息

如需更多自定义设置,建议参考官方文档进行详细配置。

使用步骤

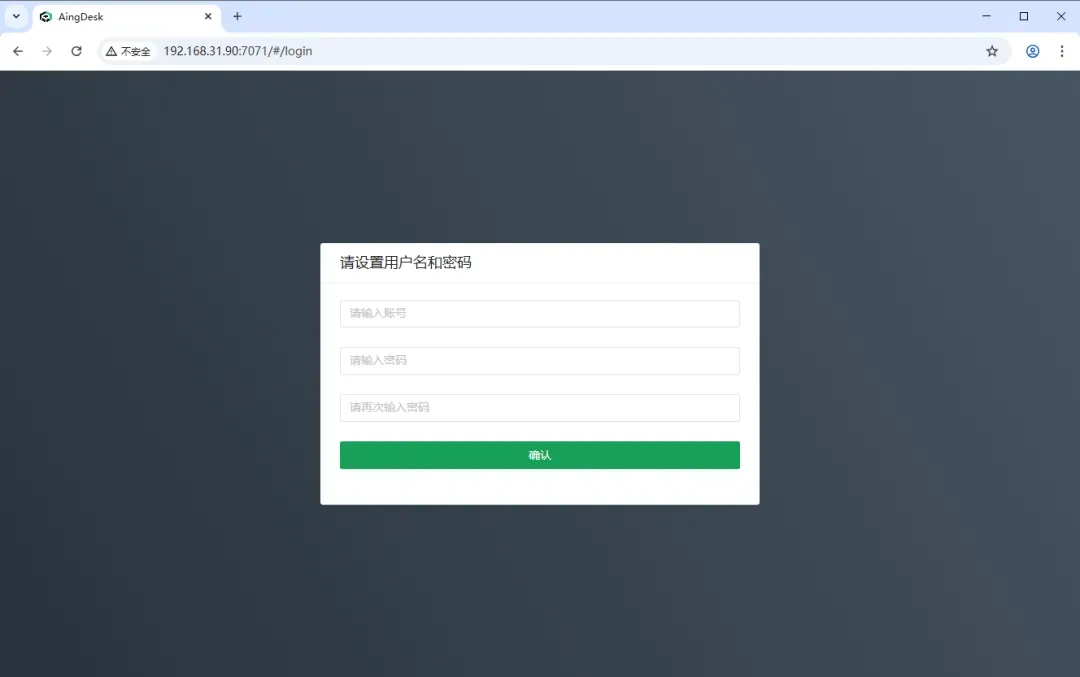

在浏览器中输入 http://NAS的IP:7071 即可访问 AingDesk 的界面。

首先设置用户名和密码以完成初始配置。

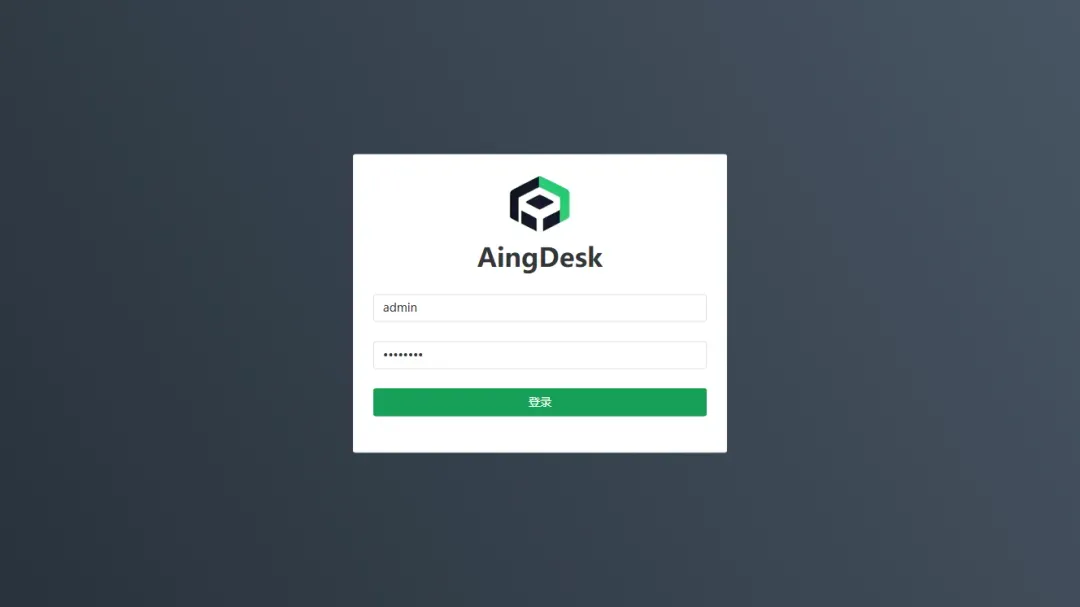

使用之前设置的账号信息登录系统。

成功登录后,您将进入主控制面板。

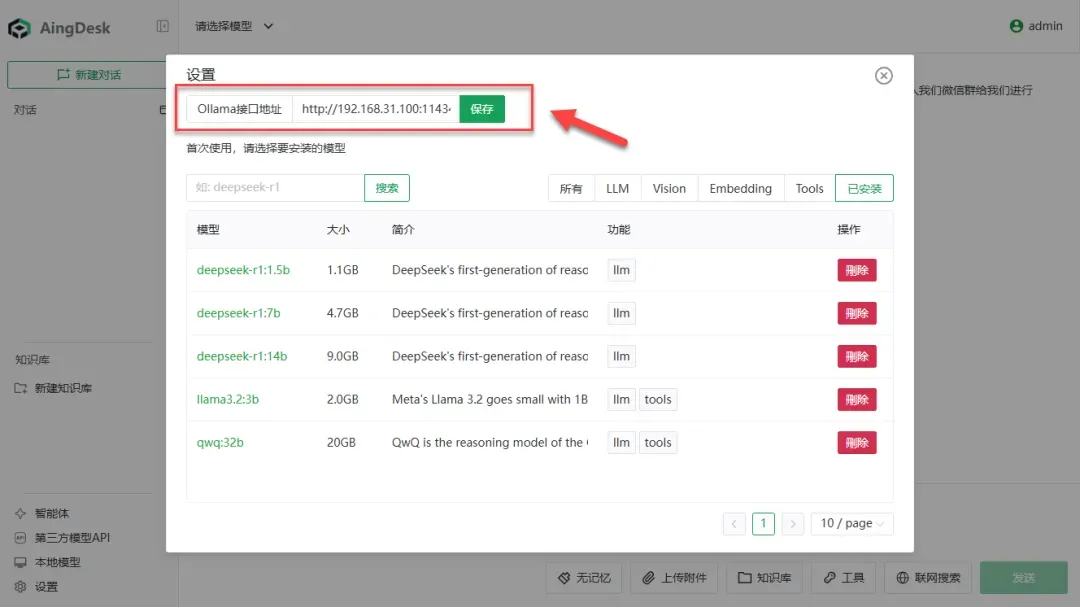

点击左下角选项,可以添加本地 Ollama 模型。

填写相应的接口地址后,即可对 Ollama 模型进行管理和配置。

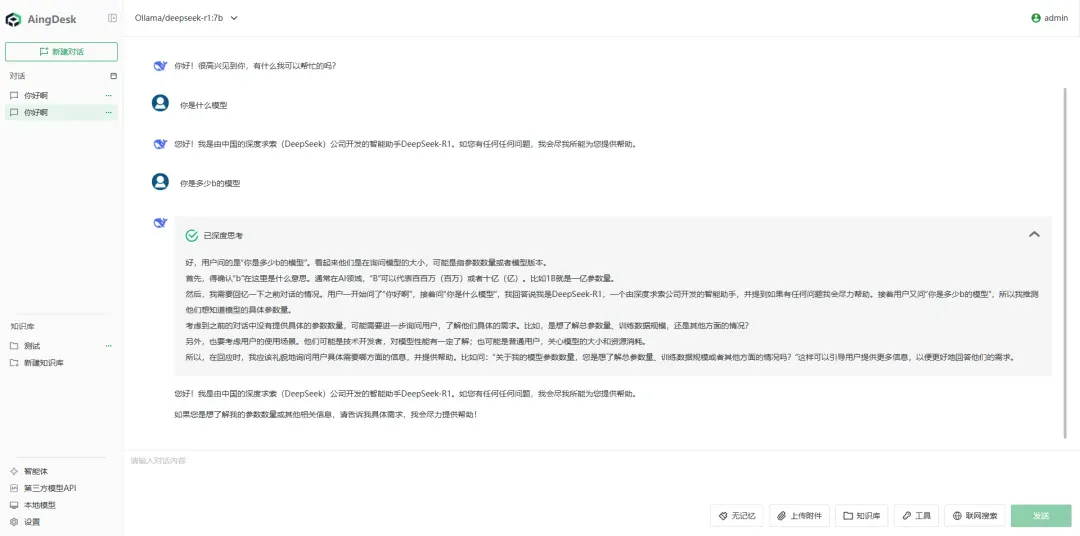

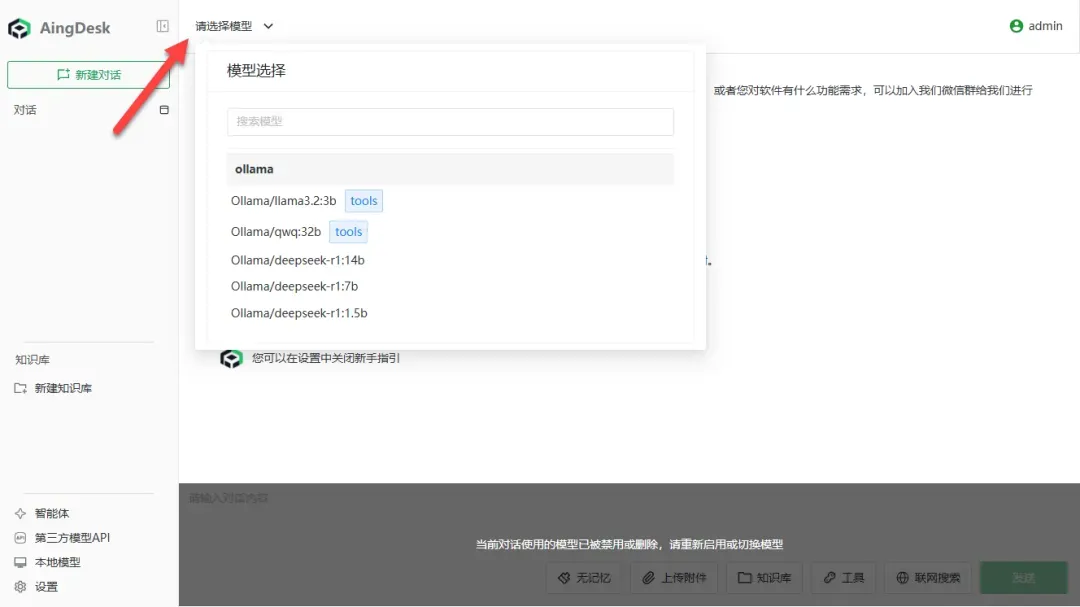

通过上方模型选择菜单,可以查看并使用已添加的 Ollama 模型。

模型调用功能正常,深度思考模式也可顺利运行。

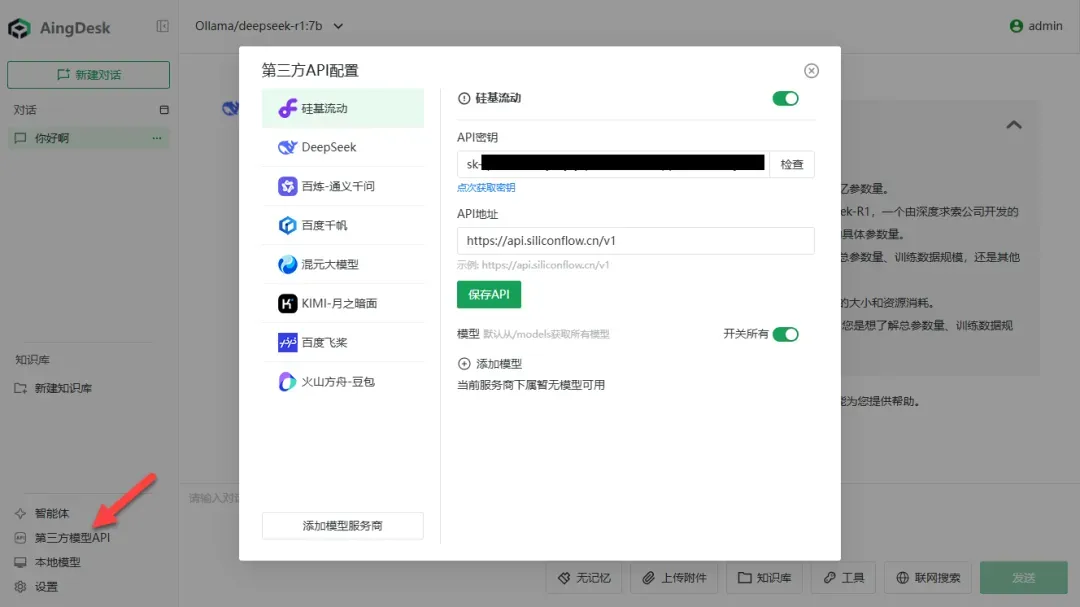

测试第三方模型 API 的集成效果。

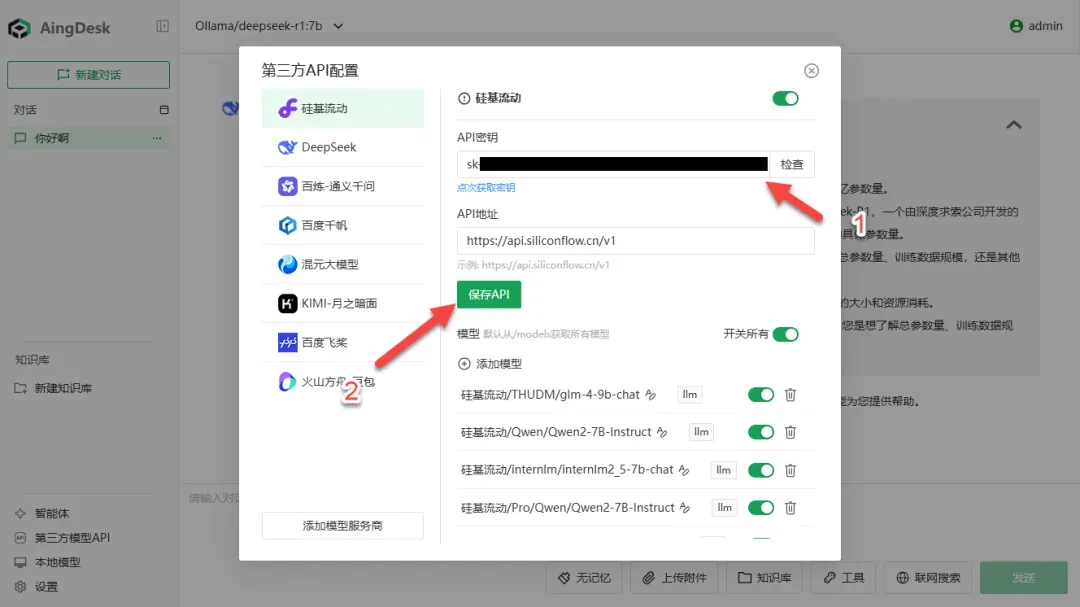

填写 API 密钥后,点击“保存 API”完成配置(如遇报错可暂时忽略)。

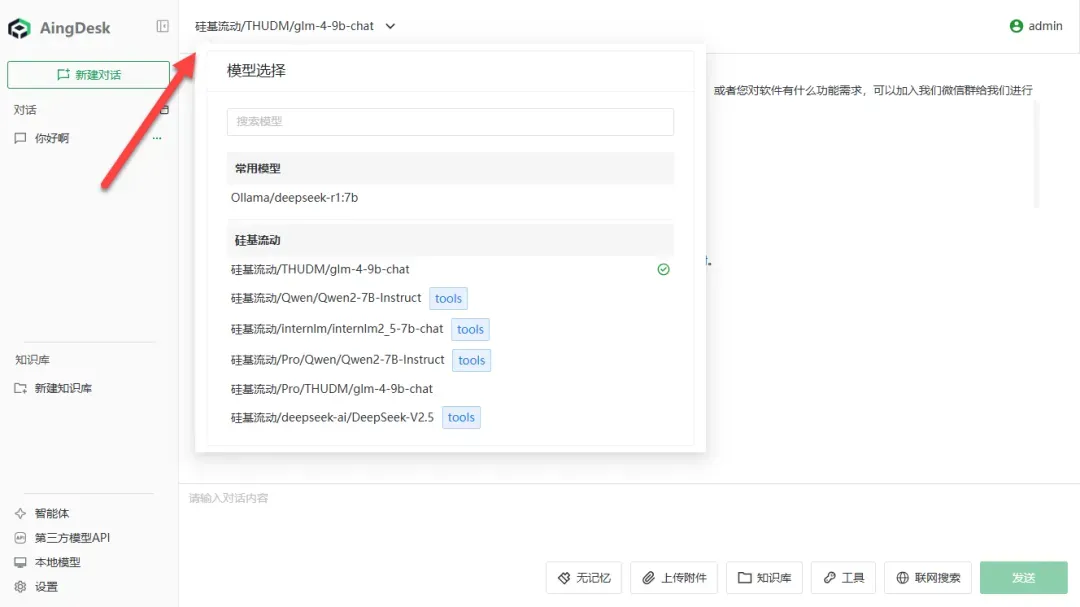

在模型选择界面中查看已添加的第三方模型。

由于采用联网调用方式,响应速度明显快于本地模型。

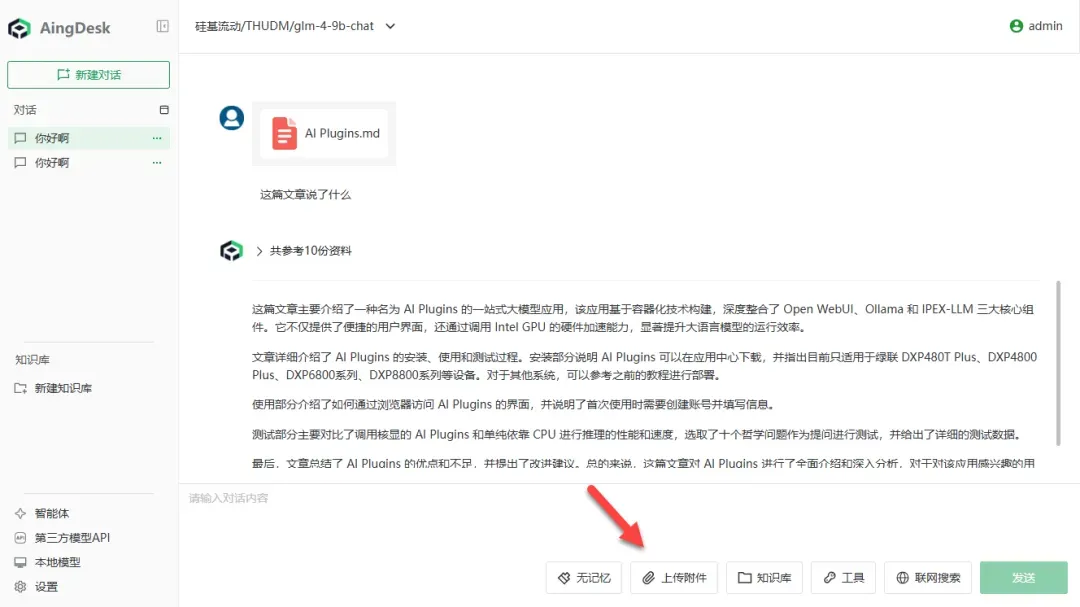

支持上传附件功能,可直接提交文档进行提问和分析。

开启联网搜索后,能够有效获取网络信息,提升问答质量。

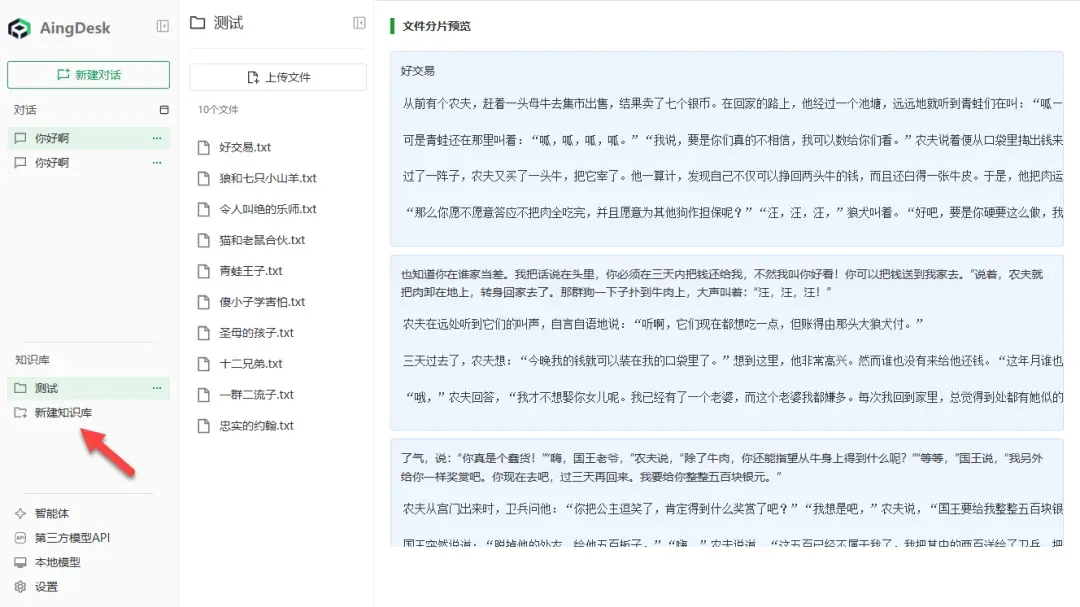

知识库创建功能运行稳定,可满足基本的知识管理需求。

总结评价

AingDesk 最大的优势在于其轻量级设计和易于上手的特性。虽然与其他同类应用相比功能不算最丰富,但各项功能设置简单直观,即使是初次使用的用户也能快速掌握。它支持联网搜索、知识库管理、用户权限设置和角色扮演等实用功能,特别适合刚接触 AI 助手的新手用户。

综合推荐指数:⭐⭐⭐(非常适合新手入门)

使用体验评分:⭐⭐⭐(操作简单直观)

部署难度等级:⭐⭐(配置过程简便)