当Gemini首次亮相时,全球开发者都为多模态AI的"视觉智能"感到兴奋——演示视频中,模型能精准分析汉堡配料或化学方程式。但很少有人深入思考:在炫目的技术展示之外,这些创新如何在现实世界的暗角点燃实用价值的火种?一位程序员通过树莓派、摄像头、Gemini和Python构建了PeregrineEye设备,给出了他的答案:在视力受损的场景下,让AI化身为"数字导盲犬",借助实时图像描述与语音反馈,帮助视障人士重建对环境的感知。这个极客风格的"第三只眼",不仅验证了多模态大模型的实际应用潜力,也揭示了技术落地过程中的严峻挑战。以下是对该项目经历的全面分享!

项目起源与灵感

PeregrineEye项目的GitHub仓库:https://github.com/peregrinAI-tech/PEREGRINEYE AutoBerry Pi项目参考:https://github.com/peregrinAI-tech/autoBerryPi

作为一名长期专注于代码的程序员,我花费了大量时间凝视屏幕。某一天,严重的眼睛疲劳迫使我以模糊的视线面对世界,这一经历深刻凸显了视力在日常生活中的关键作用。这引发了一个核心问题:当我视力暂时衰退时,作为其根源的技术——人工智能——能否转化为辅助工具?由于我正在开发另一个名为AutoBerry Pi的项目,我决定为其添加摄像头和音响组件,从而实现与大型语言模型(LLM)及周边环境的互动,目标是创造出帮助视障人士理解周围环境的实用设备。

需要强调的是,类似概念并非首创:一个引人注目的概念视频展示了一位男士使用ChatGPT辅助导航。

PeregrineEye项目并非与此竞争;它在该视频发布前已构思成型,纯粹源于我对在移动设备上测试LLM的热情驱动。

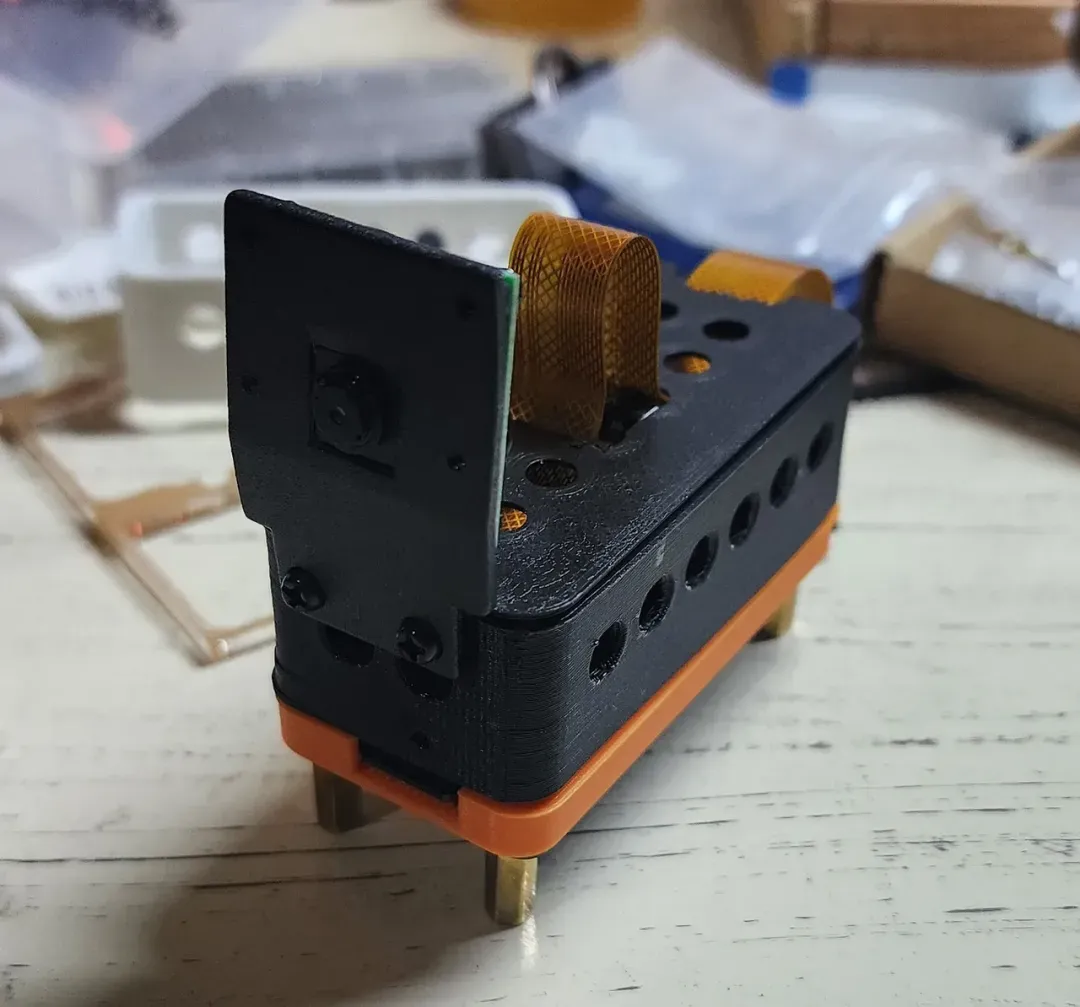

设备外观预览

以下是该相机的实物形态展示:

核心功能描述

图像描述功能:在光线充足的环境下拍摄照片后,AI相机能即时从用户视角描述图像中的元素,提供丰富细节内容。它同时将图片和音频描述保存为MP3文件,便于后续参考。

即将推出的交互式指导:未来版本中,AI相机将实现更高级的互动。用户只需告知它在图像中寻找的目标,设备会通过音频指引帮助定位物体、避开障碍或与环境互动。

构建过程详解

图像描述引擎 我们利用Gemini视觉模型分析设备捕捉的图像,生成详细描述。提示词对输出质量至关重要,当前使用的基础提示词能提供中等至良好的结果:

提示词:您是一个数字助理,需要为盲人提供视觉反馈,帮助他们在周围环境中导航。收到图像后,详细描述关键物体和结构,包括它们的相对位置和上下文信息。您的回复应简洁、清晰且信息丰富,使用户能够有效地定位自己。此外,学习并适应经常访问的地方,以提供个性化指导。您的回复要自然,并专注于提供有价值的帮助,使您的用户能够进行日常导航。 代码已从早期版本更新为:

model = genai.GenerativeModel(model_name="gemini-1.5-pro-latest")尽管Gemini视觉模型效果不错,但它并非该项目的最优选择,因为它偶尔会产生不准确描述("幻觉")。通过优化参数和模型微调,这一问题有望改善。

文本转语音(TTS)系统 我们采用Python的Google文本转语音(gTTS)引擎,将描述性文本转换为清晰的用户音频。gTTS作为易用的库,支持无限语音生成,是付费服务的理想替代方案。它能处理长文本转换,且无需付费API或额外功能,实现免费无限制的语音输出。

from button_library import Button import subprocess import os from PIL import Image from audio_library import AudioRecorder from gtts import gTTS from pygame import mixer from dotenv import load_dotenv import glob硬件组件 系统核心硬件包括:

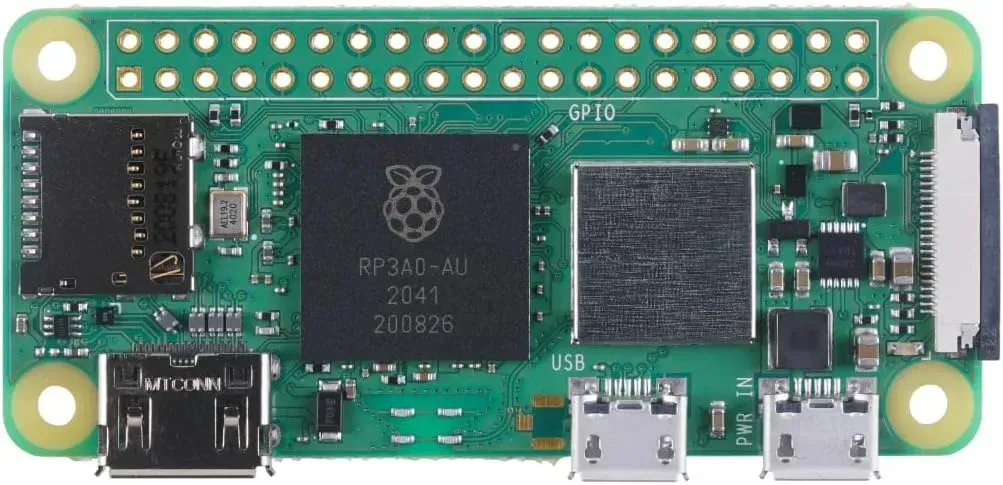

Raspberry Pi Zero 2W:紧凑且经济的微控制器,作为系统核心。

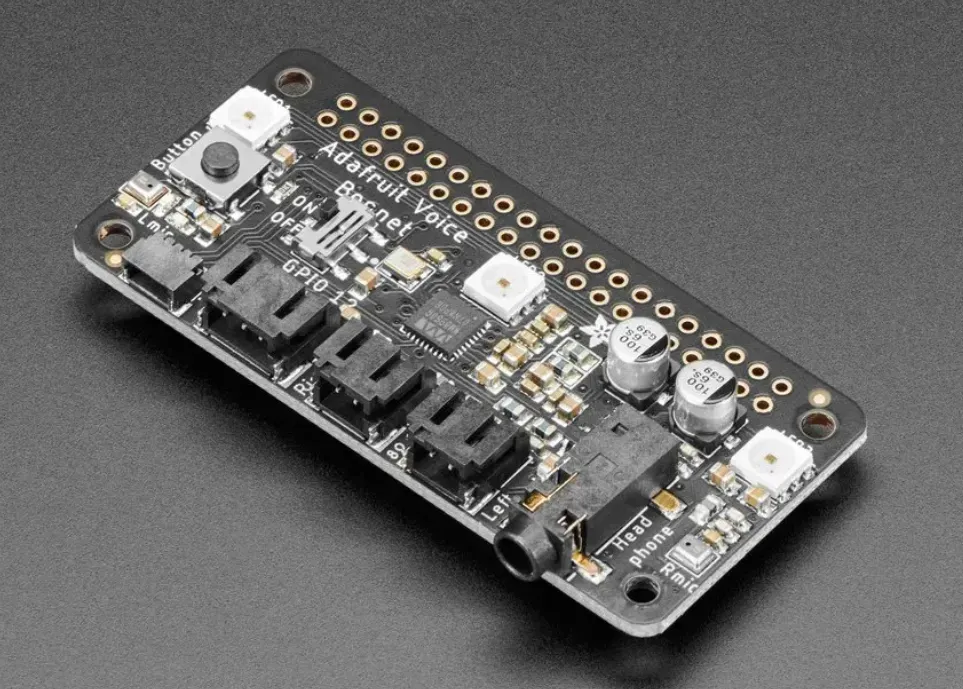

Adafruit Voice Bonnet:用于高质量音频输入输出,确保用户与设备间通信清晰。

UPS Lite:提供可靠电源,保障设备不间断运行。

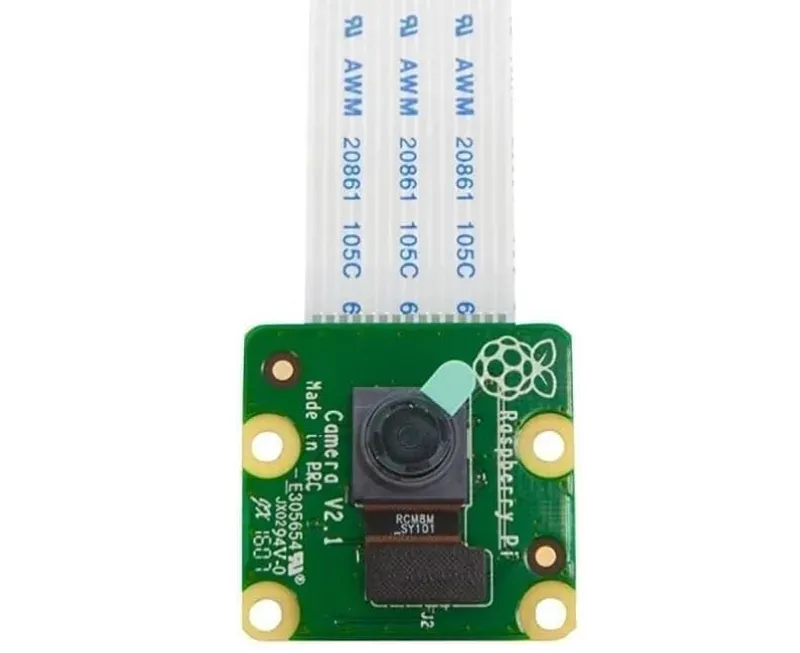

Raspberry Pi摄像头:捕获图像供实时分析。

得益于树莓派丰富的配件生态,构建此类应用原型变得异常简便。

得益于树莓派丰富的配件生态,构建此类应用原型变得异常简便。

编程实现 Python作为主要编程语言,集成各硬件组件和库,确保摄像头、视觉模型与文本转语音系统间的无缝交互。

开发中面临的挑战

照明敏感性问题

弱光条件下的性能:如预期,Gemini Vision在照明不足时准确度显著下降,导致幻觉增多和物体识别错误。

充足光照的表现:模型在光线良好的图像上表现最佳,精度更高且幻觉减少。

更新:更换相机后,图像质量明显改善,极大提升了模型性能。因此,我推荐使用原装Raspberry Pi相机。

大模型幻觉问题

物体识别错误:Gemini Vision有时会误判图像中不存在的物体,通常涉及常见场景元素。例如,它可能推断架子后有柜台,尽管缺乏视觉证据。

案例说明:模型曾错误识别广告牌上的墨西哥公众人物Lily Téllez,尽管她未出现在图片中,表明模型可能将知名人物与地点或背景关联。我仍不完全理解其错误逻辑;唯一线索可能是"VOTA"(投票)一词。

距离与细节挑战

特写图像的准确度:Gemini Vision在分析近距离图像时表现优异,细节清晰且幻觉减少。

远距离问题:相机与物体距离越大,性能越差,细节模糊导致误解和幻觉。

多任务管理难题 当前主要挑战是同时协调多项服务,包括语音生成、AI API调用、按钮与麦克风输入,并确保AI响应快速及时。

未来发展方向

麦克风支持集成 下一步是使提示词动态化,以适应实时用户需求。通过将麦克风集成到音频引擎,实现基于用户输入的自定义提示,增强交互灵活性。

API连接数据保存 计划创建端点保存图像、用户请求和LLM输出,构建全面的设备交互记录,形成用户设备互动的知识库。

RAG模块集成(检索增强生成) 目标集成模块,使设备能从外部API检索数据,通过访问额外知识源提升图像理解能力,提供更丰富的上下文解释。

项目总结与反思

坦诚地说,在超市中随意指向物体,观察LLM的识别结果——有时精准,有时偏差——充满趣味性!但这只是项目乐趣的一部分。这个小装置潜力巨大,远超娱乐范畴:想象用它从食物图像提取营养信息、在仓库识别标签,或跟踪健康康复进度。其应用场景无限广阔,我热切期待它的未来演进!

结语与社区讨论

当前大模型技术日新月异:GPT-4o的实时视频解析重塑认知,Llava-1.6在本地端实现惊艳的视觉推理。这个开源项目正处于多模态革命的前沿,亟需开发者社区的"技术众筹": 🔍 视觉模型实践:您是否部署过更"接地气"的视觉大模型?哪些开源方案在抗干扰和防幻觉方面表现突出? 🎙️ TTS技术探讨:在语音合成领域,ElevenLabs的拟真声线、Azure Neural的抑扬顿挫,或本地部署的Bark模型,谁能赋予设备更温暖的"声音灵魂"? 💡 模型扩展可能:若接入SAM图像分割模型,能否实现"帮我找到左边第三个红色罐头"的精准定位? 这场始于个人痛点的极客实验,正演变为检验AI普惠性的社会课题。欢迎在评论区分享您的见解!