📢 凌晨三点,刺耳的告警撕裂深夜宁静! 手机持续震动显示 "Nginx虚拟机强制重启!" 瞬间清醒的我意识到——线上核心服务出现重大故障!

火速登录监控平台,资源监控面板呈现惊心画面:内存占用曲线如火箭般🚀垂直飙升直至爆表! 随后Swap空间彻底耗尽,磁盘IO飙升至极限...服务器在崩溃临界点剧烈挣扎,最终触发OOM Killer的强制重启机制。

这绝非普通资源波动,内存正被无形"黑洞"疯狂吞噬!必须立即揪出真凶!

🔍 第一现场:锁定内存吞噬元凶

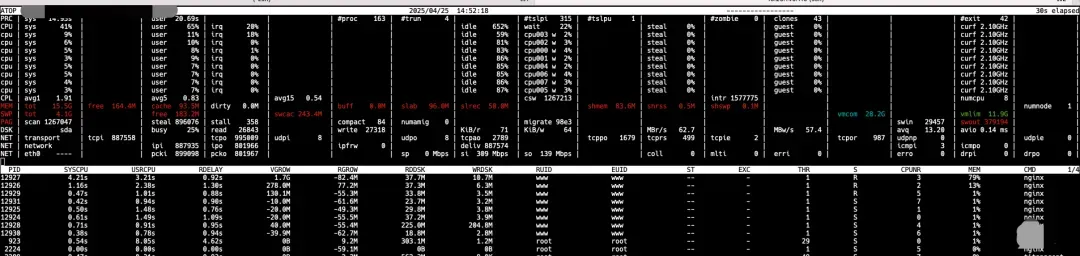

• 祭出系统级监控神器

atop,精准捕捉案发现场

• 关键证据浮现: 多个

Nginx worker进程化身"内存巨兽",将available内存持续蚕食殆尽,最终被迫调用缓慢的Swap,引发系统性卡顿直至崩溃• 初步判断: 问题根源指向Nginx内部处理逻辑

📜 日志解密:OOM事件与异常报错

•

journalctl -k | grep -i 'Out of memory':内核日志铁证确认内存耗尽触发OOM Killer• 深入Nginx

error.log发现关键线索:2025/04/24 21:11:41 [emerg] ... malloc(1073741824) failed (12: Cannot allocate memory) ... while reading upstream ... 2025/04/24 21:11:41 [error] ... [subs_filter] ngx_http_subs_body_filter error ...•

1GB内存申请失败! 异常操作竟需瞬间申请如此巨量内存?• 核心模块现身:

ngx_http_subs_body_filter(隶属ngx_http_substitutions_filter_module),该模块负责响应内容中的域名CDN替换

🕵️ 数据追踪:定位内存泄漏触发点

• 调取故障时段

access.log展开深度分析:• 锁定内存持续增长但未崩溃的时间窗口

• 重点筛查: 高频访问URL?大请求体?慢响应接口?

• 特殊关注: 近期上线的域名或新功能

• 锁定关键目标: 多个高流量且返回大体积JSON的URL接口

💣 场景复现:压力测试验证猜想

• 对可疑URL发起

ab极限压测 (ab -n 8000 -c 200 -H 'Host: ...' ...)• 内存曲线再次垂直攀升!

mpstat实时显示可用内存急速蒸发• 结论确认: 访问特定URL必然触发内存雪崩

🧩 真相揭晓:开源模块的内存管理缺陷

• 排除URL本身及上游服务异常,开源社区无相关Issue报告

• 问题直指

ngx_http_substitutions_filter_module! 核心推断:该第三方模块处理特定内容(尤其是无明确边界的大体积JSON)时,存在内存泄漏漏洞!• 关键验证: 在配置中注释

subs_filter指令后重启压测...• 🎉 内存曲线立即恢复平稳! 泄漏源100%确认!

❓ 泄漏根源深度解析

我们采用的 ngx_http_substitutions_filter_module 属第三方模块,需重新编译集成Nginx。该模块处理大型响应体(特别是流式或边界模糊内容如JSON)时,存在内存释放机制缺陷,导致每次处理请求就泄漏部分内存,积少成多最终压垮服务器。

🛠️ 三重防御方案实现根治

精准功能禁用: 对无需CDN替换的内网域名,直接关闭

subs_filter降低风险面严格类型限定: 通过

subs_filter_types指令限定仅对text/html等必要类型生效,主动排除application/json高危类型! (核心防护措施)源码级修复: 深入分析模块源码,定位泄漏点(常见于循环逻辑或异常路径的内存未释放),制作补丁并重新编译Nginx 实现彻底修复

🔧 运维利器:内存分析工具推荐

• OpenResty XRay (商业版): 章亦春团队出品,深度诊断Nginx/LuaJIT内存泄漏与性能瓶颈,适合追求高效精准分析

• OpenResty SystemTap Toolkit (开源版): 同样出自章亦春,基于SystemTap的工具集,内置内存泄漏检测脚本(

ngx-leak),需Nginx编译时开启dtrace支持• Tengine专属方案: 阿里Tengine用户可启用内置

ngx_debug_pool和ngx_slab_stat模块(需编译支持),直接分析内存池与共享内存状态

💡 血泪经验总结

第三方模块需谨慎: 即使开源模块也可能存在隐蔽缺陷,引入前需充分验证,上线后加强监控

功能边界要明确: 类似

subs_filter_types的防护指令至关重要!切勿假设模块能智能处理所有内容类型监控体系保命线: 完善的资源监控与实时告警是故障响应的生命线

日志分析破关键:

error.log和内核日志 (journalctl/dmesg) 常隐藏核心线索压测复现定乾坤: 怀疑点必须通过压测验证复现!

这场惊心动魄的"内存蒸发案"终告破解。看似简单的域名替换功能,因开源模块的内存泄漏漏洞,险些酿成线上雪崩。运维战场上,细节决定存亡,对开源组件的信任必须保持理性审视。

你的Nginx配置中,是否潜伏着类似的"定时炸弹"?🤔 立即检查所有第三方模块的使用规范吧!

你在内存泄漏排查方面有何独门技巧或踩坑经历?欢迎留言分享交流!